La visualización de datos es ya “mainstream”, un proceso que va siendo cada vez más común tanto a nivel empresarial, como en los inputs que recibimos en nuestro día a día. Sin ir más lejos, quién no espera ver alguna infografía ahora que se aproximan jornadas electorales…

Este concepto en absoluto es nada nuevo. En el antiguo Egipto ya se realizaban mapas para señalar recursos a excavar. Pero si es verdad, que hay que esperar bastante tiempo para ver visualizaciones parecidas a las actuales y con aplicaciones estadísticas o económicas…como pueden ser las balanzas comerciales de Inglaterra respecto a los países nórdicos.

Otro de los campos en los que ha ido destacado ya desde sus inicios es la Medicina. En 1850 se lograron trabajos cartográficos para intentar detectar las causas de contagio de enfermedades cómo el cólera a través de pintar en un mapa, la concentración de las muertes asociándolas a la ubicación de pozos.

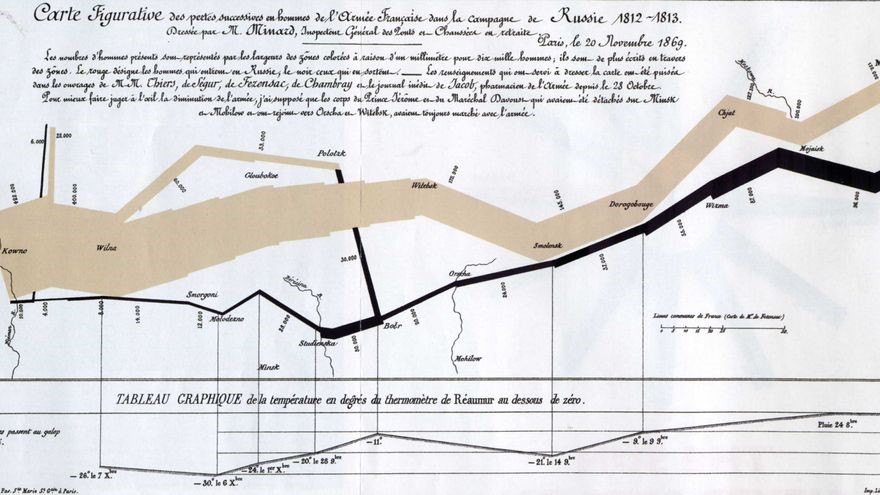

Terminando este recorrido sobre el contexto histórico, no podemos dejar de hablar de las míticas primeras infografías modernas, más complejas y con más variables del ingeniero Joseph Minard. Joseph representó las batallas de Aníbal en el intento de conquista de Roma y de Napoleón en el intento de tomar Moscú.

https://www.abc.es/20121019/cultura/abci-napoleon-rusia-bicentenario-minard-201210182015.html

Tratando de buscar definiciones más formales, se habla de la visualización de datos como “el proceso de transformación de datos en información, mediante elementos visuales con dos objetivos principales, análisis y comunicación”.

Y es que, no solamente consiste en analizar, extraer patrones e insights. Si no que se debe tener como objetivo contestar preguntas, tomar decisiones, ver datos en contexto, presentar argumentos, contar una historia e incluso inspirar…por eso hemos querido dedicar hoy nuestro post a esta fantástica disciplina.

Poniéndonos más técnicos, el paso de datos en crudo a la información y búsqueda de valor debe lograr el conocimiento del receptor de la información, evitando todo el ruido y facilitando la interpretación, pero ¿por qué mediante la visualización de datos? El principal motivo es que agiliza tremendamente el proceso de comprensión, de un solo vistazo.

Estamos acostumbrados a usar el sentido de la vista para todo, es nuestro sentido más crítico y uno de los más diferenciadores, y estamos habituados a extraer una cantidad ingente de información a través de ella. Como apunte, destacar que alrededor de 1/3 de nuestras neuronas van destinadas en exclusiva a este sentido*.

Para más inri, otro de los motivos es que, con la llegada del Big Data, cada vez generamos mayor cantidad de datos, pero la capacidad humana se mantiene estable. El gap entre dato que queremos entender y nuestra capacidad es cada vez más grande. Por tanto, la visualización de datos evita algunos problemas, colabora y complementa a las tablas y cálculos, permitiendo comprender toda información desagregada.

Como ya hemos comentado, a pesar de que esta disciplina no es nada novedosa, podemos afirmar que los proyectos y herramientas de visualización han evolucionado hasta convertirse en instrumentos cada vez más sencillos y accesibles, en gran parte gracias a la tendencia del open data y la necesidad de visualización de los datos masivos. Algunas de las herramientas más notorias dentro de este campo son Tableau (propiedad de Saleforce), Microstrategy, Spotfire, Qlik, Gephi, Carto, Power BI…cada vez más asequibles tanto en precio como en facilidad de integración para las empresas y los usuarios.

Y ahora sí, entrando ya en materia, nos gustaría mostraros de manera visual, no iba a ser de otra manera, las posibilidades y ventajas que pueden arrojar estas herramientas que agilizan y facilitan la toma de decisiones a través de interfaces amigables.

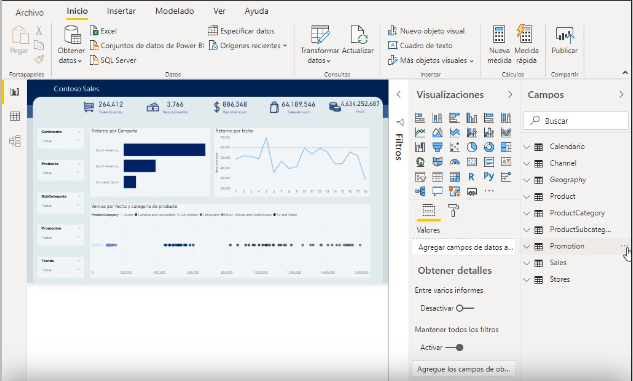

Un básico de estas herramientas es la elaboración de informes y dashboards dinámicos. Para ello, el primer paso es la extracción y transformación de los datos que queremos pintar. Estas herramientas permiten conectarse e importar datos de múltiples fuentes: archivos, BBDD, servicios en línea…de hecho, cada vez existen más API´s en el mercado que permiten esta conexión.

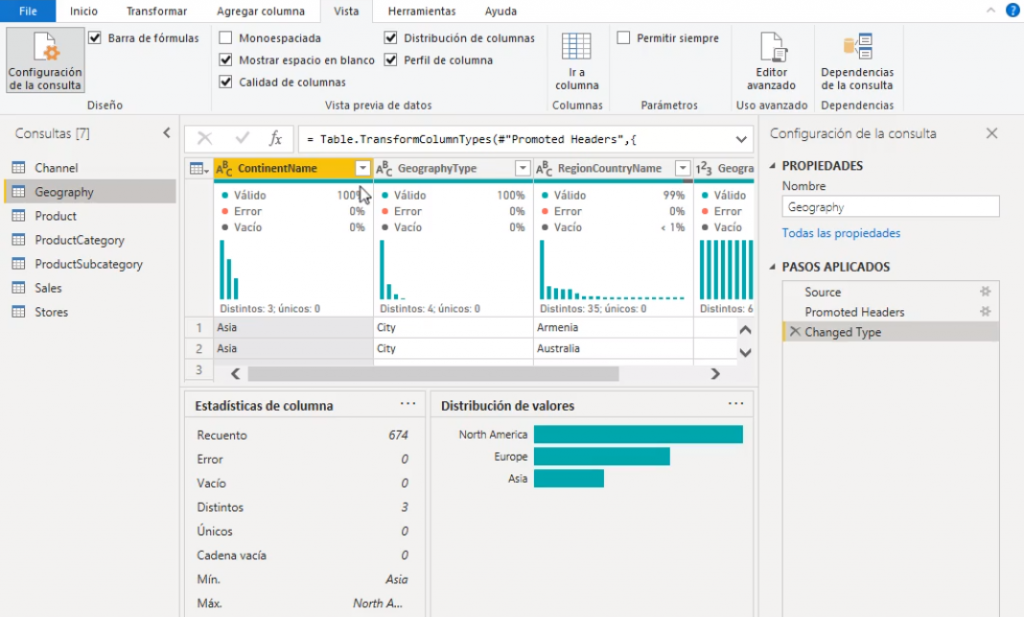

Una vez se han importado los datos, toca la parte de transformación y modificación de estos. Para ello, las propias herramientas te muestran directamente una opción donde transformar tus datos, mostrando las tablas, la relación entre ellas, sus propiedades y las opciones de configuración para nuevas consultas, además de la posibilidad de agregar columnas nuevas o aplicar estadísticos a las existentes. En esta parte es importante conocer la visual que arroja la calidad de los datos, y es posible únicamente habilitando opciones de vista sobre la distribución y perfil de columnas, mostrando los porcentajes de datos erróneos o vacíos facilitando inclusive la opción de eliminarlos directamente.

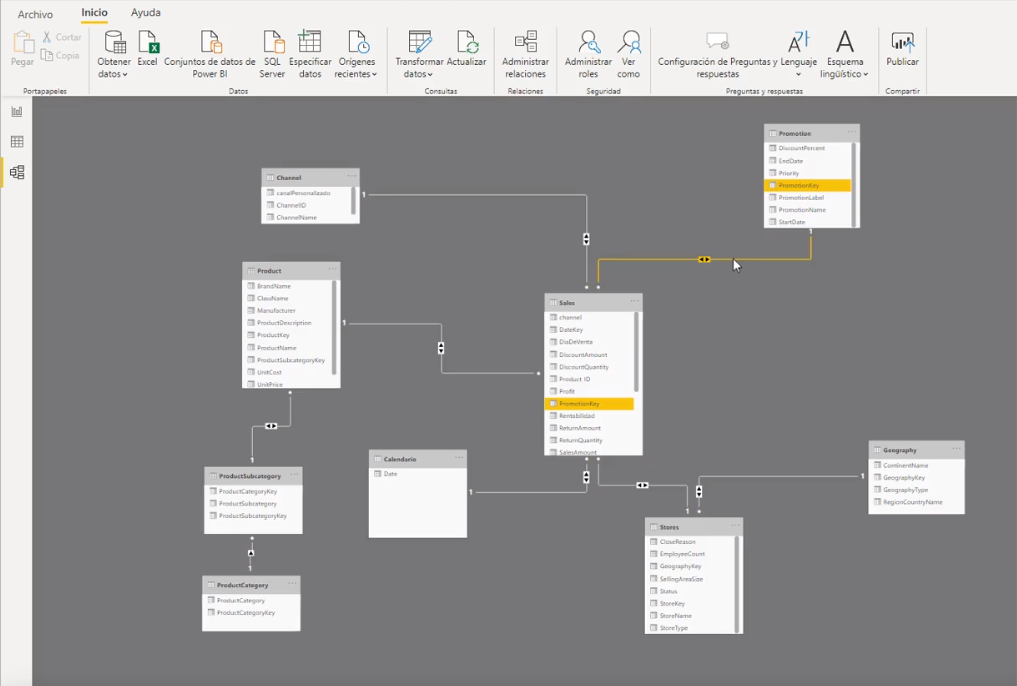

Una vez transformados los datos, pasamos a la fase de modelado, asociando tablas mediante relaciones entre columnas comunes. Para la modelización de datos, requiere por parte del usuario un conocimiento previo de conceptos como la normalización de datos, tipos de modelos de datos, llaves foraneas, llaves primarias, nociones de cardinalidad, y tipos de filtros a aplicar en cada caso. Con esta modelización vamos a conseguir reducir la redundancia y preservar la integridad de nuestros datos.

Continuando con el ejemplo anterior de Power Bi, podremos añadir métricas o columnas calculadas al modelo mediante DAX, su propio lenguaje, con una sintaxis intuitiva similar a las funciones de Excel.

Por último, tras el enriquecimiento de nuestros datos, pasamos a representarlo de forma visual. Estas herramientas proporcionan unas plantillas que, de manera sencilla, permiten arrastrar los campos que se desean mostrar, seleccionar tipos de gráficos y aplicar filtros, ya sea de forma individual como a todas las páginas simultáneamente. Además, permite relacionar las diferentes gráficas ente sí. Como principal ventaja de estos dashboards es que son dinámicos, pudiendo ver cómo se comporta la información integrada de mi fuente en tiempo real.

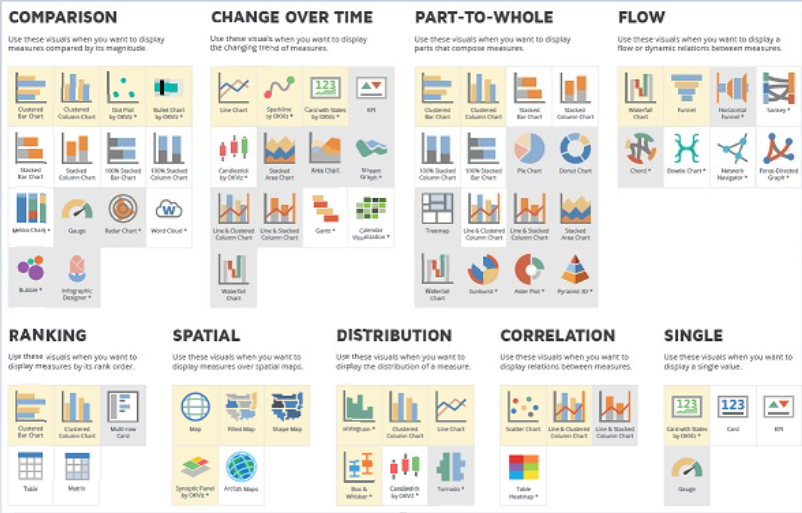

Queríamos destacar que una de las partes más importantes en la representación gráfica es utilizar el tipo de gráfico adecuado, asociado a los datos que queremos mostrar. Os dejamos en este post, una infografía muy útil para este propósito:

https://www.sqlbi.com/ref/power-bi-visuals-reference

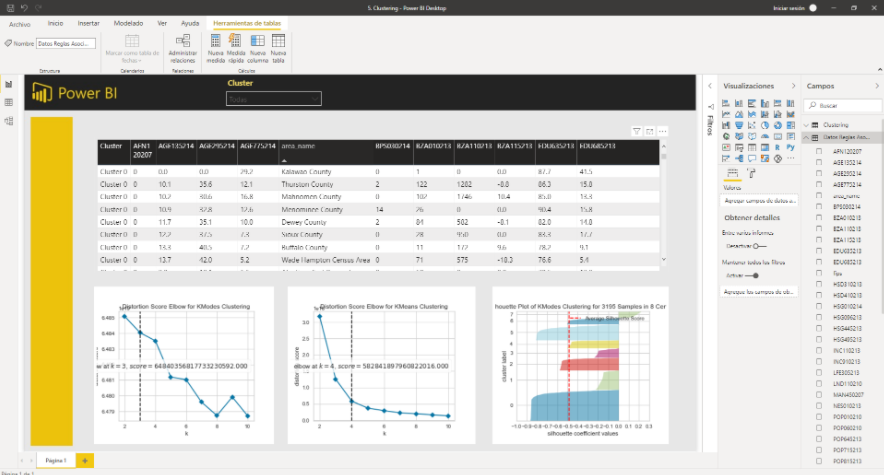

Pero como ya hemos mencionado anteriormente, la generación de cuadros de mando es solo una pequeña parte dentro de todas las funcionalidades de las herramientas de visualización. Cada vez son más completas permitiendo técnicas de análisis y visualización avanzada adaptadas a todos los niveles técnicos. Desde Integración de capacidades de IA con Python y Pycaret, la integración y evaluación de modelos de Machine Learning como clasificación, regresión, reglas de asociación, clustering y detección de anomalías, e incluso como analizar tus textos y añadir capacidades de NLP, todas ellas orientadas a enriquecer tus dashboards y que logren contestar de una forma más acertada a las preguntas de negocio planteadas.

Para concluir, y volviendo a la rama de la comunicación dentro de la visualización de datos, queríamos resaltar de la manera que se merece la figura del intérprete de los mencionados informes. Esta figura es sumamente importante, debiendo tener en cuenta a quién irá dirigido nuestro análisis, su lenguaje, la profundidad del conocimiento técnico, e incluso entender sus prioridades…de nada sirve que hayas realizado el mejor análisis del mundo, con ratios y Kpi´s haciendo saltos con doble tirabuzón, si el receptor del mensaje no lo llega a comprender. Esta mala comunicación, puede dar lugar a la paralización de proyectos, o en el peor de los casos a la pérdida de clientes que no vean claro el retorno de su inversión.

Una de las tendencias que en la actualidad se encuentran más en auge alineado con facilitar la comprensión del receptor es transmitir el dato mediante historias o storytelling. Y es que, como dijo la escritora y psicóloga Brené Brown, “Las historias tal vez son datos con alma”.

Si tenemos historias significativas, tenemos datos recordables que van a impactar y conectar mejor con el espectador, despertando su consideración. Además de generar confianza y fiabilidad a través de fijar conceptos y reportar resultados con claridad. Esto en Grupo Ideonomía lo tenemos muy presente en la relación con nuestros clientes.

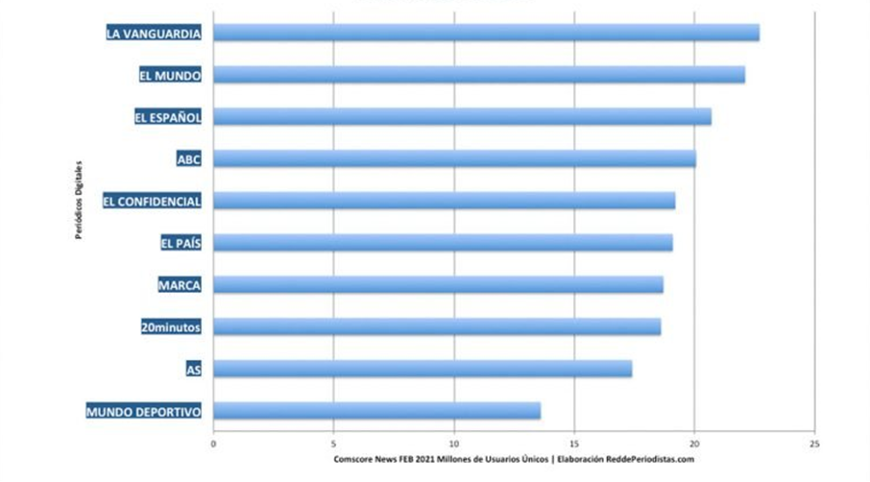

Quién nos lo iba a decir. Los diarios puramente digitales se están subiendo a las barbas de la prensa de toda la vida. La situación en el último mes registrado según Comscore, febrero, sería de empate técnico con diferencias escasas entre las principales cabeceras, desde LA VANGUARDIA, que encabeza el ranking, hasta el diario 20MINUTOS, que ocuparía la octava plaza de la clasificación

No me gustaría estar en la piel de los directivos de la prensa tradicional. El equilibrio entre la aceleración justa hacia el modelo de pago, mientras que son capaces de mantener las audiencias para seguir ordeñando la vaca (cada vez más exigua) publicitaria, es francamente inestable. La mayor competencia de los “advenedizos” digitales es además cada vez mayor ¡Vaya cuadro!

Llevo mucho tiempo escuchando que la prensa no supo hacer sus deberes. Siempre ha habido gente muy lista que hubiera podido guiar el barco hacia aguas menos turbulentas que las actuales. La realidad es que la coyuntura es muy complicada y que todos los periódicos del mundo están atravesando circunstancias parecidas.

Existen varios factores que han determinado esta situación. Quizás el factor principal haya sido la evolución del negocio de las cabeceras hacia la suscripción mediante los muros de pago. LA VANGUARDIA, después de realizar ajustes por el cambio de CMS, ha relevado a EL MUNDO en el reinado de las audiencias. PRISA, que sigue reflejando sus datos en Comscore por petición de agencias y anunciantes, UNIDAD EDITORIAL, y un diario de nuevo cuño, EL CONFIDENCIAL, son los periódicos cuyas editoriales están virando más rápidamente hacia este modelo y de ahí seguramente su pérdida de liderazgo en el ranking de Comscore.

Otros medios que han decidido apostar por el modelo suscriptor son ABC, LA VANGUARDIA y EL ESPAÑOL, pero en todos estos casos quizás el movimiento está siendo más progresivo. A pesar de que este último soporte ha endurecido su muro de pago en las últimas semanas, esto no ha sido óbice para que logre auparse al tercer puesto de la lista, desbancando de esta plaza al diario ABC.

Un hecho destacable es la consolidación de la prensa deportiva, con MARCA (Unidad Editorial), el diario AS (Prisa) y MUNDO DEPORTIVO (Godó), en el TOP-10 del aún medidor oficial de audiencias españolas.

Otro factor esencial en el intercambio de posiciones entre los diarios ha sido el de la apuesta por los canales verticales que algunas de estas cabeceras han llevado a cabo. Esta apuesta no ha sido sólo orgánica. Algunos medios han tenido que valerse de adquisiciones para tener nuevas properties en Comscore. Es imposible medir en este contexto, la influencia en la subida de audiencias derivadas de Google Discover, el nuevo algoritmo que verticaliza nuestros intereses; pero es indudable que parece un factor muy importante. LA VANGUARDIA ha realizado un gran esfuerzo en este sentido. Ampliar sus usuarios no catalanes mediante temas apropiados; mientras que se adentraba en otros segmentos con contenidos adhoc, han sido aspectos fundamentales en su éxito, logrando usuarios que con sus argumentos tradicionales nunca hubieran logrado. Tanto EL ESPAÑOL, como EL CONFIDENCIAL han tenido claros casos de éxito lanzando segmentos específicos con contenidos que han ampliado su rango de tráfico.

¡Comscore es pasado! Me refiero a este episodio con nostalgia. Tuve la oportunidad de participar en el proceso en el que se eligió a Comscore como medidor oficial en España representando los intereses de la IAB. La figura de Jaime Agulló fue clave en todo el trayecto y la consolidación de la empresa como piedra angular de la planificación digital. La Voz de Galicia ha sido el último medio impreso que rompe su contrato con Comscore. Es el cuatro grupo de comunicación que da el paso, tras PRISA (EL PAÍS, AS y HuffPost), VOCENTO (ABC) y, recientemente, UNIDAD EDITORIAL (EL MUNDO, MARCA, EXPANSIÓN y TELVA). Unidad Editorial no ha renovado su contrato con Comscore a partir de este mes. La decisión de todos estos medios está basada en las dudas que el actual medidor oficial generaba en buena parte del mercado.

Ahora es muy fácil criticar a Comscore, la ola es grande y el viento sopla a favor. Entiendo las críticas y creo que por razones que desconozco, la empresa se aburguesó y la falta de competencia acabo por dinamitar el proyecto. Que la medición se base casi exclusivamente en un indicador de volumen de usuarios, sin aportar información sobre la calidad o la fidelidad de la audiencia, aspectos tan importantes para aportar valor al medio prensa como soporte, en un ecosistema donde el inventario es casi infinito, debería haber sido santo y seña de la empresa. Comscore sigue realizando sus mediciones mensuales a través de una muestra que oscila entre los 30.000 y los 50.000 panelistas, de los cuales apenas un tercio corresponde a dispositivos móviles, pese a que el tráfico móvil es mayoritario para todas las cabeceras, y con un avance demasiado pequeño desde el comienzo de su andadura. El sistema no permite además identificar con exactitud al lector que interactúa desde diferentes dispositivos, una práctica habitual en el comportamiento de los usuarios que el medidor no ha sabido reflejar en sus métricas; pero a pesar de todo, Comscore ha sido una herramienta fundamental, utilísima para el mercado, que sirvió de base para sustentar el crecimiento del negocio durante todos estos años.

Pensaba que nunca iba a ocurrir; pero el negocio navega hacia la suscripción. El modelo hacia el pago parece un movimiento decidido. La televisión de pago ha enseñado el camino y no hay punto de retorno. Prisa, El PAÍS, ya ha logrado alcanzar los 100.000 lectores de pago digitales en menos de un año. Esta es la cifra más alta de suscriptores a un diario digital. EL MUNDO por su parte ha superado recientemente la cifra de los 60.000 abonados digitales, a los que habría que sumar los 20.000 que apuestan por la versión impresa. Las cifras son pequeñas, pero muestran el camino. ¡Dios salve a la prensa!

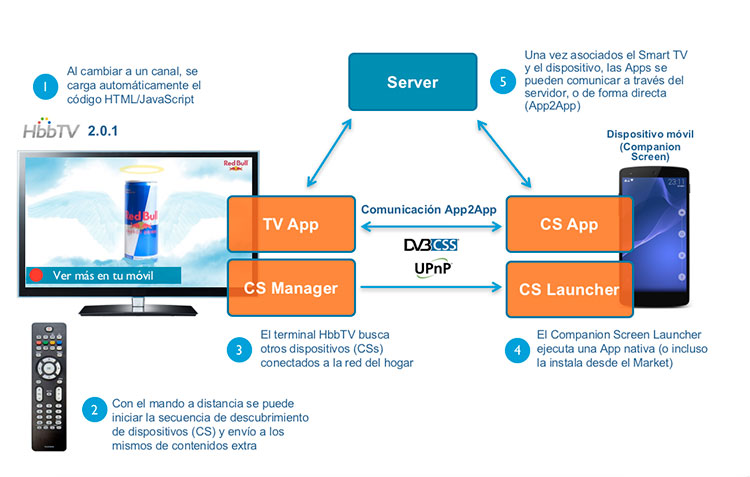

En el último post hablamos sobre el Hybrid Broadcast Broadband TV (HbbTV), o lo que comúnmente se conoce como Televisión Híbrida, un concepto no muy extendido, aunque seguramente todos la hayamos utilizado en algún momento, ya que, como dijimos en la anterior publicación, esta tecnología lleva desarrollándose e implementándose casi 10 años.

Gracias al nacimiento de las Smart TV empezamos a tener nuestro primer contacto con televisores realmente interactivos, pero no debemos confundir la tecnología Smart TV con la HbbTV. La primera es un anglicismo que hemos acogido y que, como bien dice la palabra, hace referencia a una televisión inteligente. La principal característica de este tipo de televisor es que está conectada a internet, permitiéndole ofrecer una serie de servicios digitales y conectados. La tecnología HbbTV se integra y ejecuta dentro de la Smart TV. Está diseñada para ser independiente de los sistemas operativos y entornos de los fabricantes.

Con el HbbTV no necesitaríamos descargarnos ninguna aplicación para disfrutar de los servicios que ofrece. Cuando cambiamos de canal en un entorno HbbTV, la televisión descarga y ejecuta código HTML/JavaScript de una URL. Esta tecnología se ejecuta en un navegador superpuesto al contenido que se está sirviendo en el lineal (al contenido en directo).

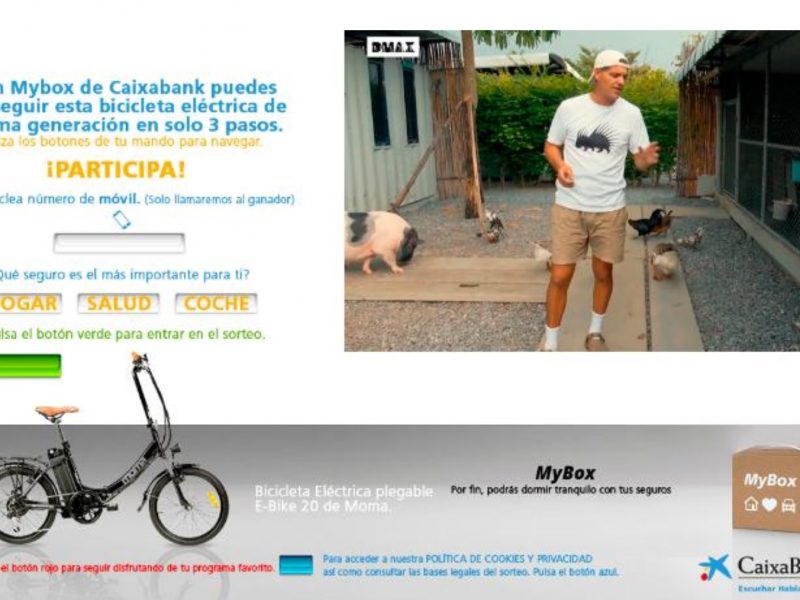

En la última publicación hablamos sobre la publicidad en entorno HbbTV y el primer broadcaster que llevó a cabo una campaña publicitaria en España basada en este estándar, Discovery Max, con el apoyo tecnológico de Konodrac y Pulsa. Esta campaña se lanzó a través de su novedoso sistema de addressable TV, Hybrids Ads, el cual permitió combinar los contenidos tradicionales emitidos en antena con un formulario interactivo que permitía a los espectadores participar en un sorteo ofrecido por CaixaBank.

Esta campaña logró un valor diferencial, ya que CaixaBank consiguió una interacción directa con los espectadores, obteniendo datos de preferencias y de contacto para utilizarlos en la venta de su producto, Mybox Seguros.

Otro paso en el que se trabaja en la actualidad es en la integración de la App TV con dispositivos móviles, que permitirán aprovechar mucho más las grandes audiencias que se manejan en televisión, para iniciar en ella experiencias que se puedan trasladar a otros dispositivos, y poder obtener mayor información de las preferencias de los consumidores:

Las oportunidades que ofrece este nuevo entorno son enormes, aunque es pronto para saber realmente cómo nos va a afectar, sobre todo con los cambios que se avecinan en la industria publicitaria digital con el anunciado fin de las cookies por parte del gigante tecnológico Google:

Adiós cookies de terceros, y ¿ahora qué?

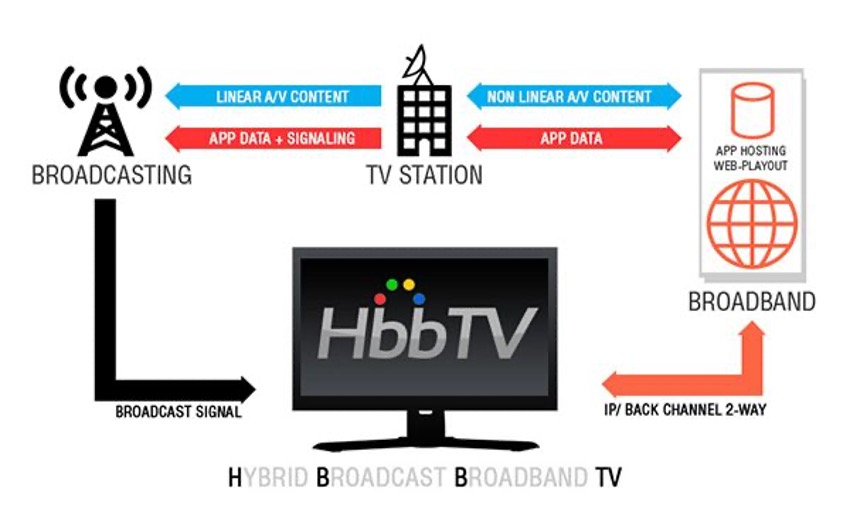

HbbTV es una tecnología que permite digitalizar la TV tradicional. Su objetivo es combinar las emisiones de televisión (broadcast) con servicios de banda ancha (broadband). Permite proporcionar un servicio de televisión tradicional y contenido web al mismo tiempo.

Una ventaja que nos ofrece la televisión híbrida es la de ver los contenidos que se han emitido en la última semana en el lineal, y la posibilidad de reproducir una película desde el inicio aunque esta haya empezado. Al tener un sistema híbrido, debemos de tener, además de conexión a internet, conexión a la antena terrestre.

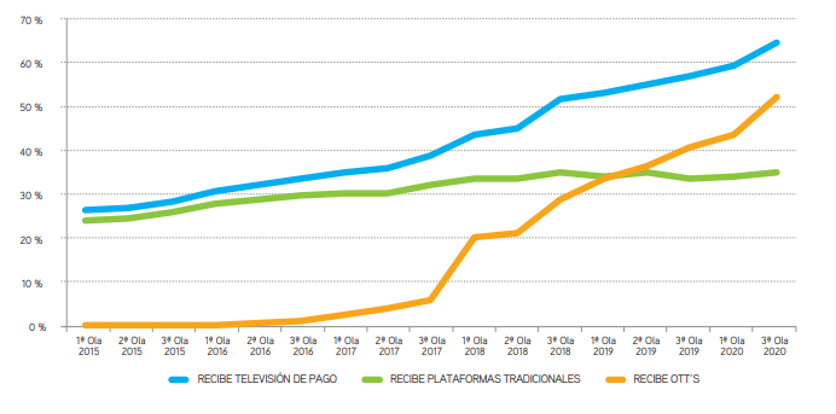

Esta tecnología lleva desarrollándose e implementándose casi 10 años. Podemos considerar este proyecto como una respuesta de la televisión tradicional a la llegada masiva de servicios de streaming como Netflix o HBO:

Fuente: Marco 2021 medios en España (AIMC)

Y es que el crecimiento de las OTTS en los últimos años ha modificado totalmente la forma en la que consumimos la televisión. Esto no quiere decir que los usuarios estén dejando de ver la televisión, simplemente acceden a ella de forma diferente.

Esto arroja un escenario muy potencial para la industria de la publicidad, no solo porque vamos a disponer de nuevos formatos publicitarios, sino por la gran cantidad de información que podemos obtener de los consumidores.

Aunque el estándar HbbTV está disponible en España desde el año 2009, es en 2019 cuando Discovery Max implementa las primeras campañas de publicidad en él.

Esta nueva tecnología permite segmentar de forma más eficiente a los usuarios, pudiendo impactarlos según sus intereses y el comportamiento que tengan en este medio.

Como hemos comentado, la televisión híbrida es un proyecto que lleva desarrollándose muchos años, pero la publicidad en ella está todavía en fase inicial, y es que existen muchos obstáculos que frenan este desarrollo, como por ejemplo, la falta de dispositivos conectados, la limitación de formatos creativos disponibles, el alto coste o la falta de control de los datos una vez lanzamos la campaña.

Todo esto actúa como freno al avance de esta tecnología, y son los grandes medios los que deberán de trabajar en común para adaptar esta comunicación y normalizarla.

El reto para los próximos años será la implantación del modelo programático en la oferta publicitaria de la televisión híbrida. Es incuestionable que este tipo de tecnología crece progresivamente, y se sigue trabajando en modelos de estandarización, tanto de medición de audiencias como en tecnología publicitaria adaptada a este entorno.

Es por ello que debemos de estar atentos a los cambios que se producen en este medio, para estar preparados y aprovechar las oportunidades que nos brinda esta nueva revolución en el sector publicitario.

En primer lugar me gustaría avisar al lector para que se abroche el cinturón porque vienen curvas, puesto que el presente post ha sido escrito por una persona de ciencias, o lo que es lo mismo, alguien que no sabe escribir en condiciones.

Bromas (o tópicos) aparte, son varios años ya los que llevo estudiando una Ingeniería y si ahora mismo alguien me preguntara que resumiese escuetamente en qué consiste a grandes rasgos dicho grado, sin centrarme en su especialidad, diría que en obtener la calidad sobre todas las cosas, en entender bien los procedimientos empleados y en prestar especial cuidado durante la realización de los cálculos.

Destacar que uno de los términos que más he escuchado durante todo este tiempo es el de calidad, concepto que tiene una naturaleza considerablemente subjetiva. Para algunas personas la calidad puede estar ligada a una gran duración de un producto, a que sea fiable, agradable a la vista, que sea ingenioso, a que un servicio sea personalizado, resolutivo, grato… Pero con el fin de acotar todas estas ideas, podríamos asumir que la calidad consiste en satisfacer las necesidades de los clientes de la manera más eficaz y eficiente posible.

Gracias a un gran esfuerzo y mucha paciencia, estoy finalizando la carrera y contra todo pronóstico, no me he quedado calvo (aún).

Aparte, también me gustaría hacer hincapié en que estuve a punto de estudiar Marketing años atrás. Personalmente, considero que produce una gran satisfacción ser el intermediario a la hora de que se realice una venta a un cliente y que tanto vendedor como comprador queden complacidos al haberse realizado la operación de manera eficaz, eficiente y optimizando los procesos de manera continua. Además, desde un principio me llamaba la atención el hecho de transmitir ideas en base a unos datos y que se produjesen tomas de decisiones basadas en los mismos.

Lo cierto es que llevo casi un mes en Ideonomía S.L. y la verdad es que me ha sorprendido la sofisticación del software empleado, la complejidad en las formas de optimizar las campañas de publicidad para las diferentes plataformas y la gran variedad de tecnicismos que se emplean día a día en esta profesión.

Los sectores del Marketing y la Publicidad están en constante evolución y se han convertido en un terreno plagado de Matemáticas, representando una parte esencial a día de hoy. Manejo de Big Data utilizando recursos tecnológicos, capacidad de realizar análisis numéricos que permitan mejorar los resultados de las campañas publicitarias, estadísticas, modelos predictivos… Todas son funciones en las que los números son los protagonistas.

Es posible que sobre un ingeniero un marketiniano piense que es difícil de entender por ser demasiado científico, que sólo pretenda estandarizar, que está muy focalizado en temas técnicos sin prestar atención a lo que el cliente de verdad está demandando, que esté centrado en hechos o pruebas, o incluso que es «de difícil trato»… Esto último por desgracia puedo corroborarlo, diciendo simplemente que según mis cálculos un 15% de la gente solo que hay en mi clase en la facultad eran Sheldon Coopers… En fin, lo importante está en el interior, eso sin duda, y Sheldon es una buena persona a pesar de todo.

Me gustaría añadir que está empíricamente demostrado que cuanto más integradas estén las áreas de Marketing e Ingeniería tanto física como funcionalmente, mejores son las expectativas de éxito en el desarrollo de nuevos productos y servicios. Dicho esto, ¿Por qué no unificar ambos departamentos? ¿Por qué no disponer de marketinianos que conocen la tecnología y de ingenieros que saben de marketing? ¿Por qué no ayudarnos y aprender unos de otros de las cualidades que hemos ido aprendiendo?

Estoy convencido de que si ambos perfiles realizamos un uso eficiente de las diferentes tecnologías y de Internet, lograr un servicio de calidad de cara a nuestros clientes en la compañía en la que nos encontramos es un objetivo que se debería cumplir sin ningún tipo de duda a través del esfuerzo de todos sus integrantes, ya que, ni todo es creatividad ni todo es matemática, pero conviene tener una visión general de ambos campos por el bien del conocimiento de cada uno de nosotros y sobre todo para lograr cumplir todos los objetivos que nos propongamos a nivel profesional en este nuestro sector.

Tal día como hoy 10 años atrás, con mucha ilusión y a sabiendas de la necesidad de proyectos como el nuestro, se puso en marcha IDEONOMÍA.

Su razón de ser fue la necesidad de especialización en la vertiente digital. Los grandes grupos tenían sus propias departamentos o agencias digitales, pero había muy poca integración con el resto de departamentos o equipos y una falta de conexión y de conocimiento integral muy elevada.

Los anunciantes desconfiaban bastante de estas opciones y buscaban la diferencia en empresas jóvenes, muy rápidas y cualificadas que les ayudaran a dar pasos rápidos en su transformación digital.

Estos 10 primeros años han pasado muy rápido y, como siempre ocurre en el mundo digital, hemos necesitado hacer muchos esfuerzos para estar al día de todo y poder ofrecer a nuestros clientes todo aquello que es relevante para su negocio y que le permite entender y controlar su vertiente digital.

Empezamos con un foco muy concreto, relacionado con las redes sociales, y 10 años después ese aspecto es algo convencional, incorporado a la estrategia general del anunciante, no siempre con criterio, pero incorporado de igual modo.

En los últimos años el interés ha ido más hacia el mundo del DATO, la incorporación de tecnología con la finalidad de identificar a los consumidores/usuarios para desarrollar estrategias de identificación, captación, retargeting etc, implementando distintas herramientas que permitieran dichas identificaciones.

También ha habido mucha inversión en compra de herramientas de CRM tipo SalesForce, Netsuite, Oracle, etc. Es cierto que con el desarrollo del negocio electrónico en España y el empuje que ha tenido para ello los marketplaces principales (Amazon, Aliexpres) ahora todos quieren vender por internet y replicar los modelos de estas locomotoras. Ni que decir tiene el hecho de que la pandemia ha multiplicado esta necesidad y ha obligado a muchos a ponerse las pilas a la velocidad de la luz.

Como siempre mucha oferta, mucha herramienta que lo hace todo con solo apretar un botón y poca integración ni valor añadido al respecto.

10 años después, ahí seguimos, en primera línea de la batalla. Mostrando a muchos el camino y divirtiéndonos con todos los cambios en los que estamos inmersos. 10 años después IDEONOMÍA tiene nuevos compañeros de camino, SIGNOMIA y PROGRAMATIC, compañeros que igualmente ayudan a hacer más fácil la integración y el desarrollo digital en los anunciantes para los que trabajamos. SIGNOMÍA en la vertiente creativa y diseño y PROGRAMATIC en la relacionada con el mundo del DATO, conformando con ello GRUPO IDEONOMIA.

Hoy me acuerdo de todos aquellos que han pasado por nuestra compañía, que se han formado con nosotros, que le han dedicado su tiempo y esfuerzo, que dejaron su impronta y que siempre formarán parte de esta familia. Son muchos, buenos amigos todos ellos, estuvieron el tiempo que quisieron estar y dieron todo lo que pudieron dar, a todos ellos desde aquí, una vez más, GRACIAS.

Mención especial a los que están ahora, los nuevos y los no tan nuevos, todos ellos sintiendo los colores y apostando por empresa pequeña, empresa donde se aprende mucho porque hay que hacer de todo y empresa donde formar piña es fácil porque la sintonía es total. Todos remamos a una!!

Por último, y no por ello de menor importancia, muchas gracias a esos anunciantes/clientes valientes que tienen la visión de incorporar a agencias como la nuestra en su pool y que nos dan la oportunidad de demostrarles nuestra valía. Gracias de corazón!!

Mientras tanto nosotros seguiremos cumpliendo años con esfuerzo e ilusión, a la espera de los siguientes 10 años, dónde espero, si no es mucho pedir, empezar a pensar en pasar el testigo.

Mucho se está hablando del cambio de paradigma en los hábitos de consumo de entretenimiento en los últimos años, especialmente si hablamos de la población más joven. La pandemia del COVID-19 ha sido un detonante más en este cambio generacional, y ha “ayudado” a Twitch (y a todas las plataformas de contenido en streaming) a crecer exponencialmente en cuanto a usuarios se refiere.

Pese a que aún mucha gente considera a Twitch una plataforma adolescente y focalizada en el universo de los videojuegos, lo cierto es que la manera de crear contenido está dando un giro hacia una parrilla de contenidos mucho más amplia y para todos los gustos. Quizá el mayor ejemplo de este cambio en España es el archiconocido Ibai Llanos, que contraprogramó las campanadas de fin de año consiguiendo más de 550.000 espectadores en el momento de la entrada de año. El propio Ibai está apostando en los últimos tiempos por un contenido menos centrado en los clásicos “gameplays” y organizando entrevistas con personajes ilustres. Hemos visto pasar por su canal a futbolistas, cantantes, e incluso presentadores de televisión.

Incluso los youtubers ya asentados en la plataforma de vídeo por excelencia están “mudándose” y poniendo el foco sobre Twitch, que reporta mayores beneficios económicos y parece tener un mayor recorrido como canal a largo plazo. De hecho, es habitual ver contenido de Twitch que los streamers (creadores de contenido en directo) reciclan más adelante para alimentar sus respectivos canales de YouTube.

Esta tendencia hacia un una gran variedad, unido a la casi infinita oferta de contenido que la plataforma morada ofrece y su sencillez de uso hace que cada vez la televisión tradicional lo esté viendo como un competidor “serio”. Clubes de futbol, artistas, emisoras de radio están comenzando a abrirse canales de Twitch.

A pesar de su creciente popularidad, la monetización y funcionamiento de Twitch aún es desconocido para gran parte de la población. El “streamer” dispone de distintas vías de ingresos en función de su “rango “en la plataforma:

Afiliado

Se piden una serie de requisitos al usuario, tales como completar 500 minutos de streaming en 30 días, hacer al menos 7 directos en el último mes, tener 50 seguidores en tu canal y alcanzar 3 espectadores promedio en el último mes.

Al desbloquear este rango, el streamer puede ingresar dinero mediante dos vías principales:

Suscripciones: Como el que paga una cuota mensual de Netflix o HBO, con la diferencia de que en Twitch la suscripción no se renueva de forma automática. Se pueden configurar distintos niveles con distintas tarifas. Es muy conocida la suscripción mediante Amazon Prime, que “regala” a sus usuarios la posibilidad de suscribirse de forma gratuita a un canal con su cuenta.

Bits: El bit es la moneda virtual de Twitch, que los usuarios pueden comprar vía Amazon. Se hacen donaciones puntuales al canal para interactuar y apoyar la retransmisión.

Partner

El siguiente nivel en la escala de Twitch. Se requieren 25 horas de directo, directos en 12 días distintos y haber alcanzado una media de 75 espectadores. Aún con todos estos logros completados no es seguro que la plataforma te otorgue el partner.

En el caso de conseguirlo, el streamer podrá incluir anuncios en sus directos, sumando esta vía de monetización a las ya mencionadas anteriormente.

Además, existe la posibilidad de los streamers, que no dejan de ser “influencers”, firmen acuerdos comerciales con marcas para anunciar productos de las mismas, pudiendo incluso llevarse comisiones adicionales por conseguir un número determinado de conversiones.

En cuanto a las distintas posibilidades de activar campañas publicitarias en Twitch, los anunciantes pueden optar por una serie de formatos muy similares a los habituales, tanto de display como de vídeo. El coste por mil impresiones en esta plataforma ronda entre los 2 y los 10 euros.

La principal novedad que trae esta plataforma es la posibilidad de realizar campañas publicitarias en el canal de un creador de contenido en específico. Esta herramienta puede tener un gran potencial para el anunciante si se conoce a la perfección el target que tiene ese streamer para lograr tener la mayor afinidad posible.

Twitch puede suponer una gran oportunidad para generar notoriedad y conocimiento de marca, sobre todo en negocios que se dirijan a un público joven (18-35 años). Sin embargo, en los últimos tiempos este espectro de edad se está viendo ampliado por el gran crecimiento que está experimentando la plataforma.

Es, además, una plataforma muy potente para fomentar la conversión para marcas relacionadas con el mundo de la tecnología (especialmente los videojuegos y aplicaciones móviles). Para esta modalidad publicitaria, las marcas suelen negociar directamente con una serie de creadores de contenido afines a su target y acordar un coste por conversión conseguida.

¿Se convertirá Twitch en una moda pasajera que acabará engullida por la televisión? Lo cierto es que a día de hoy es una incógnita. Esta plataforma ha sido menospreciada por la televisión tradicional durante mucho tiempo. Sin embargo, con cada vez más frecuencia observamos colaboraciones entre ambos “universos”, que nos hacen intuir que el futuro pasa por una convivencia entre televisión tradicional, OTTs y plataformas sociales como Twitch.

El auge de los videojuegos no ha pasado desapercibido para nuestro sector, un sector cambiante y dinámico, que ha descubierto en los videojuegos, una caja de pandora de la cual extraer soluciones para algunos de los problemas crónicos que presenta la publicidad tradicional.

Es el caso del advergaming, un fenómeno poco conocido en nuestro país por falta de explotación, pero que ya ha sido utilizado en varias ocasiones por grandes marcas a nivel internacional como McDonald’s o Volkswagen.

Si bien es cierto que surgió hace más de 40 años no ha sido empleado hasta la última década por las marcas en sus estrategias de publicidad. Se considera por tanto un fenómeno reciente que surge de la fusión de entretenimiento y contenido publicitario.

Pero bueno. ¿qué significa esto del advergaming?

Para que todos los entendamos, es una técnica que mezcla publicidad y videojuegos. Esto significa que una marca crea un videojuego alrededor de una idea publicitaria para impactar al usuario de forma no intrusiva. El usuario tiene la intención de probar el juego por tanto es un formato de publicidad no invasiva que favorece el recuerdo de la marca por parte del usuario.

El público afín a los videojuegos ha estado estereotipado durante muchos años lo cual repercutía en una falta de interés e investigación por parte de las marcas.

Gracias a la incorporación de las redes sociales (YouTube, Instagram, Twitter) y a la aparición de plataformas de streaming se ha dado a conocer un sector y un público con gran potencial para las marcas lo cual ha dejado atrás el estándar de varón, adolescente, entusiasta de la informática que pasaba 24h delante de una pantalla.

Según el Anuario 2019 de la AEVI el perfil de los jugadores es en un 58% hombres y en un 42% mujeres lo que demuestra la diversidad de géneros en la industria. El rango de edad es muy amplio (6-64años) y se trata de un público muy segmentado y con gran diversidad de intereses lo que ha provocado que las marcas se fijen en el a la hora de realizar sus campañas de publicidad.

Por otra parte, el avance de la tecnología, especialmente de los teléfonos móviles hace cada vez más viable este tipo de publicidad.

Estas son algunas de las ventajas que puede ofrecer esta técnica al sector:

Es una forma no intrusiva de comunicar e impactar al usuario. Sin interrumpirlo y sin causar molestias al espectador ya que él mismo decide probar el videojuego lo cual es favorable al recuerdo de la marca.

Es personalizable y adaptable a los estándares de la marca que diseña el videojuego.

Fácil de viralizar y óptimo para reforzar la imagen de marca.

Permite la creación de bases de datos gracias a los leads que se recogen mediante la descarga del videojuego. Además, es un método para crear comunidad y fidelizar a los usuarios.

Al contrario de otras técnicas tradicionales, la comunicación con el usuario es bidireccional pues el usuario da respuesta a la marca mediante el uso del videojuego. Es un diálogo entre usuario y marca.

Como comentábamos previamente, es una técnica que no ha tenido mucha cabida en España, pero existen varios casos de éxito que acreditan su potencial:

En primer lugar, “Magnum Pleasure Hunt” de la prestigiosa marca de helados Magnum, quien lanzó una campaña de advergaming en la cual el usuario, controlando una bailarina, tenía que recoger chocolates de diferentes webs como YouTube o Spotify. Esta campaña logró atraer a más de 7 millones de personas.

Por otra parte, Ilumination Entertainment, compañía productora de películas como Gru “Mi Villano Favorito” también se puso manos a la obra con una campaña de advergaming. Diseñó un juego de plataformas en el cual controlabas a un minion (personaje de la película Gru). El juego logro más de 6 millones de descargas.

Estados Unidos nos lleva años de ventaja en cuanto al estudio e investigación del advergaming. Diversos ensayos se han encargado de analizar el comportamiento del consumidor respecto a este formato de publicidad con la finalidad de extraer conclusiones que prueben su posible eficacia.

En el caso de nuestro país, el estudio realizado por Sara Catalán y Eva Martínez arroja conclusiones muy positivas sobre el uso del advergaming.

Por ejemplo, los advergames permiten que los consumidores estén expuestos al mensaje publicitario más tiempo. Estas ratios de exposición son mayores a la publicidad tradicional. También que conforme aumentan el número de partidas, aumenta su actitud favorable respecto a la marca.

Por supuesto, este formato de publicidad tiene limitaciones, pues no se puede demostrar a ciencia cierta que resulte en un incremento de rentabilidad.

En España, la llegada del advergaming ha sido efímera. Aunque encontramos campañas como “Controla” de la Red Eléctrica Española no es una acción publicitaria en la que se invierta mucho presupuesto. Las marcas siguen haciendo foco en otros campos dentro del sector de los videojuegos como los eSports o los influencers de gaming.

Por otra parte, no existen empresas especializadas en nuestro país lo que hace más complejo el lanzamiento de campañas de esta categoría. El lanzamiento de un advergame no es tarea sencilla, requiere de una planificación y un diseño minucioso en el que cada mensaje cuenta. Un mal advergame pude influir negativamente en la marca.

Como hemos podido ver, el advergaming posee un gran potencial y son muchas las ventajas que puede ofrecer esta técnica a nuestro sector. Esperamos que las marcas españolas comiencen a incluir el advergaming en sus acciones publicitarias y con ello dar un toque de aire fresco al sector.

Esperamos que hayas disfrutado del artículo, nos vemos la semana que viene.

En la última publicación de este blog, hablábamos sobre la generación del dato externo por parte de las marcas y de las diferentes herramientas y tecnologías que participan en ese proceso, también comentamos que, en la mayoría de los casos, los datos que se recogen son cookies de terceros.

Pero hay dos temas aledaños respecto a estas cuestiones que, por la extensión de uno de ellos en concreto, no incluimos en el anterior post y sobre el que merece la pena poner foco, fundamentalmente por la trascendencia que tiene para la activación publicitaria digital de las cookies de terceros por parte de las marcas.

El primero, tiene que ver con la vigencia de las cookies, puesto que como sabemos, éstas disponen de un determinado tiempo de vida, en función de su utilidad y configuración para su posterior activación publicitaria. Es por lo que se hace necesario, volver a realizar una activación sobre las mismas para que estas audiencias no se pierdan.

Por otro y más importante por los cambios que supone, fue en su momento el anuncio del principal navegador en España de eliminar las cookies de terceros (Chrome) que como ya hemos comentado, se utilizan para la activación publicitaria y que dejarán de tener vigencia en el año 2022, lo que provocará durante este 2021 diversos cambios y adaptaciones para un futuro sin estas cookies.

Hasta el momento varios son los escenarios de adaptación a la desaparición de las 3third party cookies para los especialistas del marketing en su acercamiento publicitario al público objetivo:

Huella digital: Utilización de una metodología para identificar probabilísticamente a un usuario sin cookies mediante la combinación de una serie de señales (dispositivo, navegador, sistema operativo, dirección IP, idioma, etc.) permitiendo en base a la probabilidad identificar a un usuario único, asignándole un user ID, para después poder targetizarlo.

Nativo + Contextual: Este acercamiento al target objetivo, parte de una segmentación basada en la supuesta relevancia e interés de un anuncio para el usuario, en un contexto específico y adecuado para mostrarlo.

Publicidad + IA: Sistema que fusiona la combinación de lo humano y la máquina, es decir, creación de la campaña con sus peculiares segmentaciones (targeting, sites adecuados, ubicaciones, creatividad, etc.) más la optimización realizada a través de maching learning (algoritmos) para que encuentren patrones comunes que puedan incentivar el rendimiento final de la campaña.

ID universal: identificador utilizado por todas las plataformas (oferta y demanda) para la identificación y el targeting. Esta solución crearía un first party cookie entre las entidades asociadas en este modelo, evitando la necesidad de crear nuevas reglas de codificación y facilitando la identificación en las múltiples plataformas. A priori esta sería una de las mejores soluciones, pero de momento solo se podría utilizar en aquellas plataformas que lleguen a dicho acuerdo y no tendrían cabida en las plataformas cerradas “walled gardens” como Facebook o Google

Salas libres de Publisher o “Clear Rooms”: lugares donde los gigantes como Amazon, Facebook y Google comparten datos agregados de los clientes con los anunciantes (generalmente a través de terceros neutrales), lo que les permite combinar sus datos propios con los datos agregados de los clientes obteniendo una vista completa del targeting publicitario. Esto permitirá controlar la sobreexposición de los usuarios o ser capaces de detectar nichos o posibilidades aún sin explorar. La parte negativa de esta opción es que, al estar implicados los gigantes tecnológicos, los datos que se generen no podrán salir del entorno y ser aprovechado por las marcas para una posterior activación.

Por último, la mejor opción pasa por poseer tus Propios Datos, de hecho, las cookies de origen no están expuestas a tal extinción (de momento) por lo que una marca que pueda hacer que los usuarios se identifiquen cuando están en su entorno (Loguin) dispondrá de una información muy importante para poder emprender acciones de márketing con objetivos específicos.

A estos pasos dados a nivel global por la industria se unen los movimientos particulares manifestados por algunos de los actores principales en este negocio, como el anunció dado por Google a finales del pasado mes de enero con la solución propuesta a esta nueva situación.

En dicho comunicado el gigante de California ha anunciado a la Industria que dispone de su propia solución a la desaparición de las cookies de terceros. Solución a la que ha denominado “FLoC”, acrónimo de Federated Learning of Corts o “Aprendizaje Federado de Cohortes”.

Aunque no es definitivo, Google indica que, según sus pruebas, los anunciantes obtendrían con este sistema un 95% de conversiones por dólar gastado si se compara el anterior modelo. Es decir, solo tendrían una pérdida del 5% respecto al ecosistema de cookies de terceros.

Este sistema, permitiría la targetización de los usuarios basada en intereses generales, agrupando grandes grupos de personas que comparten intereses similares. A estos grupos los denomina “cohortes”. Para realizar esto, el navegador alimentará a un algoritmo de aprendizaje automático con los datos de los sitios web que visitan los usuarios, de tal manera que en función del comportamiento que desarrolle cada uno de ellos los introducirá en unos grupos u otros.

Como positivo frente a las cookies, Google declara que con FLoC, los datos individuales de navegación de los usuarios no salen de su navegador, es decir, el navegador no declararía los sitios particulares que ha visitado el individuo, sino que emitirá un “ID de cohorte” al que pertenece el usuario (en función de una serie de intereses), por otro lado si estos grupos “cohortes” son suficientemente grande, Google indica que no será posible el rastreo individual, por lo que la privacidad de los individuos será respetada.

Como negativo, es que aspectos como la medición, el retargeting o el control del fraude que se realizaba a través de cookies con FLoC no están solucionados.

Con todo, a partir de marzo FLoC estará disponible en un entorno de pruebas y será en el segundo semestre de este año, en el que los anunciantes podrán comenzar a probarlo, teniendo en cuenta que para que este sistema pueda funcionar y sustituir en un futuro a las cookies, las webs deben utilizarlo.

Fuente: blog.google

Las marcas generan en su interacción con los usuarios una ingente cantidad de datos (fundamentalmente los que se producen de forma externa) que en la mayoría de las ocasiones no se aprovechan adecuadamente, bien sea por desconocimiento a la hora de establecer el proceso de recogida y normalización o bien por el uso de las plataformas que se necesitan para implementarlo.

Pero ¿cómo es y qué plataformas o herramientas participan en el proceso de generación de los datos externos de una marca?

Esta data es la que se recoge fuera del entorno de la propia marca y en la mayoría de los casos está estrechamente relacionada con la activación publicitaria, por lo que su control es muy importante, fundamentalmente por varios motivos:

Suele ser fruto de una inversión cuantiosa.

Proporciona un mayor volumen de datos respecto a la data interna.

Complementa y enriquece la propia data interna, a través de la modelización del comportamiento de los usuarios en su interacción con la marca.

Esto a su vez permite a la compañía incrementar la eficiencia del negocio.

Por otra parte, el flujo de datos desde fuera hacia adentro aporta cuantiosa información externa sobre el negocio que redunda en la posibilidad de abrir nuevos caminos de crecimiento.

¿Cómo se produce la generación de la data externa?

Los usuarios son impactados de forma recurrente por cualquier tipo de campaña y en cualquier dispositivo por las Marcas generando múltiple información con cada una de ellas.

Por ello, las compañías deben recoger y gestionar esta información una vez que llega a su entorno, de la manera más eficaz posible.

Para la generación de estas campañas y por ende todo el conjunto de datos del que hablamos las Marcas utilizan diferentes tecnologías que sirven para activar, recoger, gestionar y volver a activar los datos según los propios objetivos de cada una de ellas.

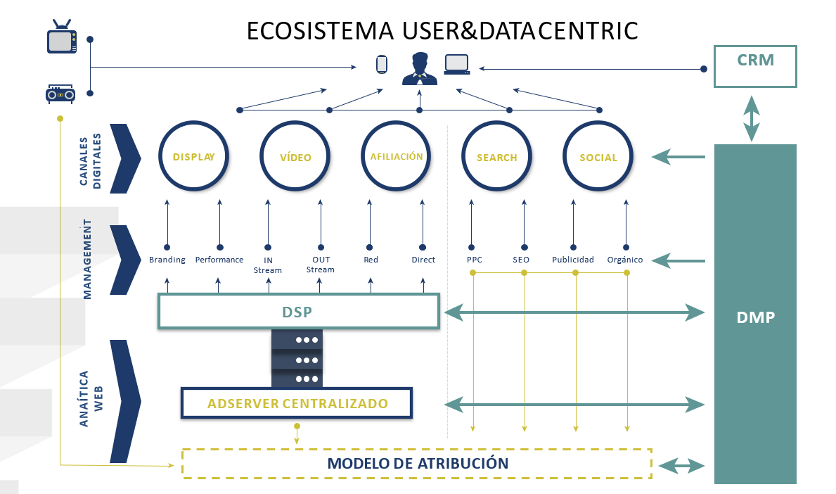

Normalmente las plataformas o herramientas implicadas en la activación de las campañas y recogida del dato generado con las mismas son:

Adserver (servidor de publicidad) Plataforma que permite subir, gestionar y controlar todas las campañas que se pongan en marcha en el entorno digital con cualquier otra plataforma de activación publicitaria (Display, Vídeo, Móvil, etc.) En esta plataforma el principal dato que se recoge, son las cookies de los usuarios que han sido impactados o han realizado cualquier interacción con dichas campañas.

Cookies: pequeño fichero de texto que se almacena en el navegador del usuario y se convierte en un identificador único (navegador, no usuario, aunque en la mayoría de las ocasiones es el mismo.) El principal objetivo es balizar a los usuarios para poder impactarlos después en base a su comportamiento.

DSP (Demand Side Platform) Plataforma que se utiliza para la compra de publicidad de manera automatizada, pujando impresión por impresión, por las cookies que más interesan a los anunciantes. El dato que se recoge con esta plataforma son cookies de los usuarios impactados, así como de los que interaccionan con las campañas. Esta herramienta permite activar en campaña las cookies recogidas en el adserver en el que se alojan las campañas (mientras las cookies tengan vigencia)

DMP (Data Management Platform) Plataforma de gestión de datos, que nos permite recoger, categorizar y almacenar la data (cookies) procedente de las diferentes campañas realizadas por la marca, para su posterior uso en la activación publicitaria, con el objetivo de lograr una mayor cualificación y eficiencia de esta activación.

Con esta herramienta, las marcas también pueden realizar la integración de su data interna, gestionada a través de la herramienta CRM (Customer Relationship Mangement) a través del macheo de los ID de los correos de los clientes con el ID del DMP, esta acción permitirá la categorización y activación posterior del dato.

Otras plataformas que proporcionan datos a nivel externo son aquellas que sirven para el enriquecimiento de la información obtenida en los canales sociales a través del social loguin, un ejemplo de ello es Xeerpa.

En este caso, como en el caso de los datos internos de CRM, son datos declarados (mail con el que te has dado de alta en las plataformas sociales) con lo que posteriormente se puede machear a través de su ID con el ID del DMP, lo que permitirá por un lado el almacenamiento (segmento) de esta audiencia enriquecida y la activación posterior del misma para tratar de conseguir un mejor rendimiento publicitario.

Por otra parte, dentro de la activación publicitaria hay determinadas plataformas (walled gardens) como es el caso de las RRSS, Buscadores o Amazon con las que se realizan campañas publicitarías, pero de las que solo puedes sacar los datos de interacción, normalmente clics. Para obtener una parte de la data utilizable (cookies) de estas campañas es necesario que:Las campañas se trafiquen (suban) a un adserver donde se recogen las interacciones generadas

Activar a través de un DSP, un reimpacto sobre esas interacciones para recoger las cookies generadas y almacenarlas en forma de segmentos en el DMP.

En resumen, el flujo de datos internos – externos y el manejo de las diferentes plataformas de manera interna por las compañías tiene como objetivo fundamental conseguir, la mayor eficacia y eficiencia posible en la activación publicitaria, así como conocer de primera mano, como es el cliente real y el objetivo, otorgando a las marcas de la posibilidad de abrir nuevas vías de negocio que esta información les proporciona.

GrupoIdeonomía comprometidos con los anunciantes para guiarles en sus activaciones publicitarias. Contacta con nosotros sin compromiso.