En la mayoría de ocasiones y circunstancias, actuamos por necesidad, si esto lo trasladamos al ecosistema digital y por poner algún ejemplo, en el caso de aquellos que tienen un negocio y que quieren dar a conocer sus productos o servicios, la necesidad de obtener visibilidad resulta primordial… Visibilidad en aquellos lugares donde pueden ofrecer esos servicios y productos y donde pueden dar respuesta a las búsquedas de los usuarios.

Como usuarios, cuando tenemos cualquier inquietud o necesidad por satisfacer, el primer lugar donde buscamos respuestas, es en internet (aunque luego tengamos que realizar cierto cribado), y dentro de internet y como el 97% de los españoles, dentro de Google.

El gigante de internet, no solo dicta las reglas, sino que hace que resulte indispensable seguirlas para poder trabajar los objetivos de visibilidad que tienen las marcas, tanto es así que, si hablamos de visibilidad en buscadores, Google cambia y actualiza constantemente el algoritmo de su motor de búsqueda, con la intención ofrecer los mejores resultados a los usuarios a partir de lo que interpreta como la mejor experiencia de este dentro de los sites que visita.

Esto significa que si quieres tener visibilidad, como opción para obtener resultados para tu negocio, tienes la obligación de estar al tanto del funcionamiento del algoritmo del buscador, como de las actualizaciones que de manera frecuente tiene por costumbre lanzar para seguir dictando las normas.

En este sentido, a finales de 2019 comentábamos en nuestro blog, una de las actualizaciones más importantes Google, respecto al posicionamiento orgánico (SEO) de los sites en su buscador: BERT y de cómo esta actualización pretendía, en base al entendimiento del “contexto” en las búsquedas, cualificar la experiencia de los usuarios.

Pero, antes de continuar, debemos tenemos que tener claro, que la tan anhelada visibilidad pertenece o se circunscriben dentro del posicionamiento en buscadores y que este, como todos sabemos, se puede trabajar de diferentes ópticas:

Como sabéis, al realizar cualquier tipo de búsqueda, dentro de las SERP (Search Engine Results Page) hay dos tipos de resultados:

. Orgánicos: resultados mostrados por el buscador, sin necesidad de invertir en la plataforma para obtener resultados en un corto – medio plazo.

. Pagados: resultados expuestos como anuncios, en donde los anunciantes han invertido diferentes recursos (entre otros, económicos) para potenciar la visibilidad de sus negocios.

En próximos posts ahondaremos aún más en estos últimos, pero hoy hemos querido enfocarnos en cómo los resultados orgánicos se ven afectados por las actualizaciones que implementa Google.

En noviembre del año pasado, unas semanas antes del Black Friday y de la época navideña, con la última y tercera actualización del año, muchas webs sufrieron una reevaluación de sus contenidos, y como es lógico, algunas sufrieron caídas por no cumplir con los parámetros establecidos. Google trata de potenciar el contenido de calidad para los usuarios, y mostrar aquel contenido que se ajuste lo máximo posible a las búsquedas realizadas. Esta es la razón principal por lo que es tan importante hacer una revisión de los contenidos que ofrecemos para así ofrecer la máxima calidad a nuestros usuarios.

Tras esta última reevaluación, muchos de los principales sites sufrieron caídas en su visibilidad; y otros, como los casos de Aliexpress o la Casa del Libro tuvieran por el contrario incrementos en su visibilidad.

¿Qué más cambios ha ofrecido Google en el último año?

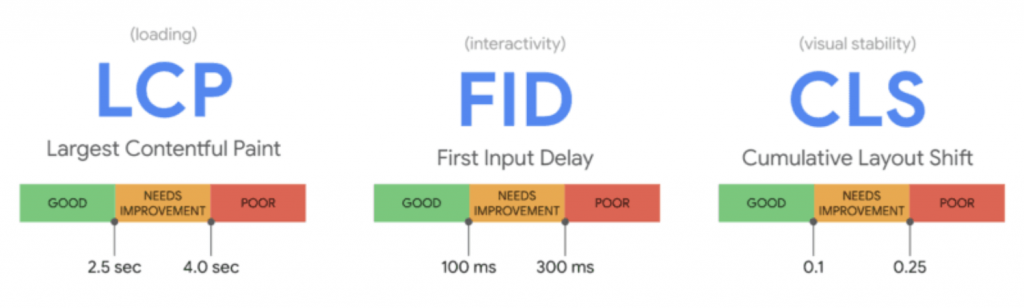

El año pasado Google anunció más cambios, que continuaban con esta tendencia. Estos cambios se centraron en la experiencia de la página y las reseñas de calidad, Core web vital, un sistema de métricas, indicadores para la experiencia de usuarios y que “se aplican a todas las páginas web, y deben ser medidos por todos los webmaster, y que, desde ahora, aparecerán en todas las herramientas de Google. Cada uno de los Core Web Vitals representa una faceta diferente de la experiencia de usuario, es medible y refleja la experiencia del mundo real de un resultado crítico centrado en el usuario”.

Una de las principales ventajas que ofrece la extensión es que es gratuita y que ayuda a los desarrolladores a implementar las mejoras necesarias para convertir sus webs en sitios de calidad.

Los Core Web Vitals se basan en tres indicadores específicos.

Fuente: Google

Largest Contentful Paint

Destinado a medir la velocidad de carga de la página, determinando el momento en el que el contenido principal de la web se ha cargado por completo y, por tanto, es útil para los usuarios (determinándose que la carga debe realizarse entre los 2,5 – 4 segundos) considerando como lento todo lo que supere este tiempo de carga.

First Input Delay

Mide el tiempo de carga que transcurre desde la primera interacción del usuario con la web hasta el momento en que el navegador es realmente capaz de responder a esa interacción.

Google establece que para que se considere una buena experiencia de usuario, el FID debe implementarse entre los primeros 100 – 300 milisegundos, considerando como lento todo resultado superior.

. La medición y la evaluación de este parámetro solo se va a poder medir entre usuarios reales, es decir, no se podrán establecer simulaciones para probar este tiempo de carga.

Cumulative Layout Shift

Esta última métrica es aquella que evalúa la estabilidad visual de las webs. Es decir, analiza todos aquellos cambios de diseño inesperados que pueden confundir al usuario, y así tener una mala experiencia. Un ejemplo claro puede ser el movimiento inesperado de los textos sin que los usuarios hayan podido interactuar con ellos, lo que puede ocurrir cuando los recursos se van cargando de forma irregular).

Se han establecido herramientas para poder medir el buen hacer de las implementaciones:

. Herramientas de campo: Estas herramientas recogen la experiencia de los usuarios que interactúan con la web con datos provenientes de usuarios reales.

. Herramientas de laboratorio: Entornos de prueba, simulando el comportamiento de los usuarios.

Los Core web vitals nos ayudan a evaluar y medir el trabajo que realizamos para aumentar la visibilidad de las webs. Posteriormente al lanzamiento de esta metodología, se han ido publicando actualizaciones del algoritmo que priman la experiencia de los usuarios y la calidad de contenidos que se le ofrecen.

El futuro mira por la seguridad de los usuarios y nosotros lo hacemos por la de nuestros clientes.

Si necesitas más información sobre las actualizaciones del mercado, no dudes en ponerte en contacto con nosotros.

Bibliografía

Agencia SEO de posicionamiento online | Vandelay.es

En qué consiste la actualización del algoritmo de Google (junio 2021) (isolated.es)

Cómo afecta a las reseñas el nuevo algoritmo de Google 2021 (iebschool.com)

Google lanzará un nuevo algoritmo en junio de 2021 (trecebits.com)

5 trucos ocultos de Google Search Console (trecebits.com)

Como comentábamos en la anterior publicación, varias son las soluciones que la industria plantea para tratar de mitigar el efecto de la no sincronización de las cookies de third party en los navegadores. En este sentido os habíamos hablado de la primera de ellas, la opción de agrupar a los usuarios en función de su comportamiento en la navegación propuestas por Google o Microsoft entre otros.

La segunda de las alternativas está basada en el desarrollo de un identificador de información personal (PII) “Personal Information Identifier”

-Solución de identidad Unified ID 2.0 Propuesta por The Trade Desk en el que, las cookies son sustituidas por direcciones de correo electrónico anónimas que son recopiladas a lo largo del recorrido digital del usuario, ya sea cuando inicia sesión en un sitio web, en una aplicación móvil o de smart TV, de cada correo electrónico se genera un identificador anónimo y cifrado (hash) dando respuesta a tres de las demandas del mercado: anonimización, transparencia y mayor control para los usuarios

–ID+ de Zeotapp basado en 4 principios: Independencia, sencillez, interoperabilidad y cumplimiento normativo. Tanto en la parte de las marcas como en la de los publisher funciona de manera similar a UID2.0 generando un identificador único a partir de las direcciones de correo de los usuarios. El problema al igual que ocurre con The Trade Desk es la necesidad de sincronizarse con el resto de tecnologías, lo que puede suponer un contratiempo para este tipo de soluciones si en la industria no hay consenso.

–RampID de Liveramp, solución determinística que permite a los anunciantes convertir los múltiples identificadores diferentes que los consumidores generan en dispositivos, plataformas de marketing y en sus propios sistemas internos, en una persona real, generando un identificador único que cumple los criterios de privacidad a nivel consumidor. En la parte de los editores funciona de manera similar al resto de opciones, generando el ID a partir del email del usuario posteriormente hasheado.

Otras soluciones de identificación

–TCPF de IAB Spain propuesta encaminada a impactar al tráfico no autentificado, este sistema basado en el Transparency and Consent Framework (TCF) de IAB EU funciona de la siguiente manera: TCPF utiliza uno de los propósitos incluidos en el CMP para solicitar el consentimiento para la generación de un ID universal, en el momento en que el usuario da su consentimiento, es redirigido a un dominio central en el que se genera el ID depositando una cookie de primera parte en el navegador del usuario y devolviendo al usuario al dominio local donde se ha generado el consentimiento sincronizando con el mismo el ID. Dicho ID estará accesible en el dominio central para aquellos proveedores incluidos en el CMP local. Según la propia IAB Spain se ha creado una solución necesaria puesto que aporta al ecosistema diversas ventajas:

-Fácil integración

-Disponibilidad para cualquier actor dentro del ecosistema

-Da respuesta al tráfico no autentificad

-Es una iniciativa por y para la industria.

-Aporta una capa extra de privacidad

–SWAN iniciativa generada por parte de diversas empresas del ecosistema publicitario digital para dar respuesta al tráfico no autentificado y cuyo fundamento pasa por ofrecer un modelo de identificación que no tenga necesidad de los datos personales. Se basa en la generación de un ID anónimo que se “descentraliza” siendo redireccionado entre todos los miembros de la red SWAN. Como principales ventajas de este sistema encontramos:

-Mejor experiencia de usuario pues reduce las solicitudes de consentimiento repetidas, accediendo al contenido de inmediato.

-SWAN permite un registro de auditoría transparente de las empresas que procesan los datos de las personas, así como la posibilidad de bloquear anuncios molestos y denunciar a los infractores.

-Resguarda la intimidad, disponiendo de identificadores seudónimos y respaldando los términos que todos los participantes en la red deben aceptar.

-Los participantes en la red se “agrupan” para competir contra los Walled Gardens a su vez es un sistema verdaderamente descentralizado en el que todos los participantes son iguales.

–ID5 se trata de una solución que resuelve la complejidad de la identificación en la publicidad digital al ofrecer capacidades de medición y reconocimiento de usuarios que priorizan la privacidad. El ID5 permite a los editores y anunciantes crear y distribuir un identificador propio compartido a todo el ecosistema. El ID está encriptado para que las plataformas tecnológicas puedan pasarlo o conectarse con ID5 para descifrarlo y usarlo para ofertar, mejorar la entrega de campañas y medir el desempeño o agregar datos y construir segmentos. ID5 vincula las ID’s de usuario entre dominios utilizando métodos deterministas cuando los sitios web pueden proporcionar «señales duras», como direcciones de correo electrónico con hash o ID’s de inicio de sesión/SSO. Cuando estas señales no están disponibles, ID5 procesa las “señales suaves” proporcionadas por el sitio web (como los datos disponibles en las solicitudes HTTP) utilizando un algoritmo probabilístico que señala las posibilidades de que a un usuario ya se le haya atribuido un valor de ID universal.

Como veis hay donde elegir, pero además no son las únicas soluciones propuestas por el mercado, en este sentido, Panorama id de Lotame (solución global de identificación basada en personas) o las soluciones de inicio de sesión único propuestas por otros actores del mercado (Verini, Netid, Nononio o Media Pass) ponen de manifiesto como la industria no termina de ponerse de acuerdo en la unificación de un modelo que permita adaptar y trabajar a todos los actores implicados bajo el mismo identificador único.

Por otra parte, los grandes dominadores de este ecosistema, los denominados Walled Garden (FB, Google, Amazon…) tampoco están muy interesados en facilitar las cosas a la industria, sobre todo cuando ellos tienen asegurado el tráfico autentificado y las posibilidades de targetización intactas.

Queda mucho camino por recorrer en este 2022 antes de que la moratoria dada por Google a la sincronización de las third party cookies se cumpla y con ello veremos si finalmente se produce la alianza de intereses, en principio necesaria, entre las diferentes partes para tratar de llevar a buen puerto este tema.

Mientras tanto, ¿vosotros cómo estáis afrontando este difícil reto…? Nosotros en Grupo Ideonomía estamos muy pendientes de los movimientos de nuestros socios tecnológicos y en este sentido vemos complacidos como uno de ellos, Adform ha dado importantes pasos para resolver este problema creando ID FUSIÓN un sistema generado para proporcionar un servicio de traducción entre todos los tipos de identificadores y unificarlos. Esto se hace siendo completamente independiente de cualquier identificador, ya que Adform otorga a los anunciantes, agencias y editores la capacidad de elegir qué datos usan, sin las restricciones de los problemas de compatibilidad que afectan a la industria en general y las soluciones limitadas de la competencia.

Este sistema, probado en diferentes campañas durante el pasado año, ha obtenido hasta el momento resultados más que satisfactorios, lo cual nos hace estar tranquilos y mirar con optimismo el futuro, con la certeza de poder ofrecer a nuestros clientes un escenario solvente para la activación de sus campañas.

Hace cerca de un año publicamos en este mismo blog, un post sobre la desaparición de las cookies de terceros en 2022, a raíz del comunicado lanzado por Google en ese momento, en el que ponía en conocimiento de la industria que no iba a permitir la sincronización de este tipo de cookies en su navegador, y las consecuencias que esto tendría para el mundo publicitario, teniendo en cuenta que las third party cookies son creadas por empresas diferentes del sitio web en el que el usuario entra a navegar, entre ellas, las mismas empresas de publicidad.

Las cookies de terceros, como ya sabéis, permiten a los anunciantes ofrecer anuncios relevantes en función de los diferentes intereses de los usuarios, es decir, este tipo de “códigos” en principio y en un “entorno ideal” están enfocados a que los usuarios disfruten de una mejor experiencia de navegación ofreciendo en ella, productos relacionados con sus intereses. Por otro lado, es obvio que estos anuncios sirven también, para financiar el contenido que el usuario consume.

Como os decía en aquella publicación hablábamos de las diferentes alternativas que la industria estaba poniendo encima de la mesa para tratar de solventar esta pérdida de información, con el horizonte puesto en 2022, momento en el que entraría en vigor la decisión de Google de no permitir la sincronización de este tipo de cookies, en su navegador.

Pasado un año y con la moratoria que Google ha dado hasta 2023, fundamentalmente por el retraso en la puesta en marcha y pruebas de su sistema de Cohortes “FloC”, la idea de este post es, hacer una actualización de las diferentes opciones que baraja la industria y sus principales actores frente a esta eventualidad.

Como la mayoría de los que nos encontramos en esta industria, sabemos que, en la batalla por la identificación del tráfico, las cookies de primera parte se han convertido en las verdaderas protagonistas de la fiesta y que solo los sitios que posean un tráfico los suficientemente importante, van a poder seguir construyendo sus propias audiencias, siempre y cuando este tráfico no suponga en cuanto a alcance, un obstáculo insalvable.

El problema es que, los sitios web que pueden disponer de sus propias audiencias son relativamente pocos, por lo que la industria se ha visto abocada a dar diversos pasos con el objetivo de encontrar alternativas que puedan sortear el próximo escenario cookieless con garantías, planteando hasta el momento diversas soluciones apostado por diferentes planteamientos:

Soluciones basadas en la agrupación por categorías, tomadas por algunos de los gigantes tecnológicos, como Google o Microsoft

Google, en su intento de seguir controlando el ecosistema publicitario una vez desaparecidas las cookies de tercera parte, apuesta por un sistema llamado Privacy Sandbox. Esta solución basada en “cohortes” y compuesta por diferentes APIs tiene como principales propuestas:

“FloC” que como ya comentamos en su momento, usa un algoritmo que se ejecuta en el navegador del usuario y analiza los hábitos y preferencias de los mismos a nivel individual según los sitios web que ha visitado. En base a estos comportamientos, los usuarios son asignados a un grupo o segmento para que los anunciantes puedan impactar a esa cohorte con anuncios específicos a sus intereses.

“Fledge” desarrollada para poder poner en marcha la parte de Remarketing, de tal manera que cuando un usuario visita la página de un sitio en la que desea anunciar sus productos o servicios, el sitio (anunciante) puede solicitar al navegador del usuario que lo asocie con grupos de interés específicos durante un periodo de tiempo determinado (por ejemplo, 30 días). FLEDGE satisface los casos de uso de remarketing, pero está diseñada para que no pueda utilizarse por terceros para rastrear el comportamiento de navegación de los usuarios. La API permite que el navegador realice «subastas» en el dispositivo para elegir los anuncios relevantes proporcionados por los sitios web que el usuario haya visitado anteriormente.

Microsoft por su parte utiliza un concepto similar para la agrupación de los usuarios en función de sus intereses, con la diferencia de que el algoritmo en lugar de ejecutarse sobre el navegador, lo hace sobre un servidor proxy que se interpone entre el usuario y la empresa publicitaria, este sistema denominado Parakeet es capaz de enmascarar los datos privados reales del usuario a partir de la generación de ruido estadístico que permite anonimizar datos como:

El editor que solicita el anuncio

El lugar geográfico desde el que usuario solicita el contenido La IP del usuario que hace la solicitud y algunas más que tienen como objetivo de proteger la privacidad del individuo.

Si estáis interesados en seguir profundizando, en como la industria está buscando soluciones cookieless, no os perdáis el próximo post en el que haremos un recorrido por el resto de alternativas propuestas hasta el momento.

Biblografïa:

Este pasado año 2021 ha sido notorio para todos nosotros por muchas razones, entre otras, por la aparición estelar de un nuevo término tecnológico, los NFT.

El NFT, traducido al inglés, “Non Fungible Token”, hace referencia a un identificador único digital, catalogado en cadena de bloques y utilizado para registrar la propiedad de un archivo. Esto, quizá te suene a chino, pero dicha cadena de bloques se refiere a la Blockchain, la cual hemos tratado previamente en este blog.

(Por si te interesa, te lo dejo por aquí para que puedas informarte antes de entrar en materia con los NFT. https://www.grupoideonomia.com/blockchain-aplicado-al-marketing/ )

Volviendo al tema en cuestión, la Blockchain permite la trasferencia de información o de archivos, de tal forma que nadie pueda modificarla gracias a sus parámetros criptográficos, de ahí su relación con las criptomonedas.

Pues bien, esta tecnología es subyacente tanto a NFT como criptomonedas, y, sin embargo, son conceptos contrarios. Te lo explico a continuación.

El NFT no puede ser intercambiado por otro, pues se trata de una propiedad única, es un bien no fungible. En contraposición, la criptomoneda, al igual que los euros, puede ser intercambiada por otra o por varias, ya que no posee unicidad, es decir, son divisibles.

Como venía comentando, la Blockchain aporta a los NFT la capacidad de ser únicos e inmodificables, por lo que solo puede existir uno en toda la red. Para que se entienda mejor es útil compararlo con una obra de arte, por ejemplo, El Guernica de Picasso es único y sabemos que está situado en el Museo Reina Sofía. Al igual que ocurre con las obras de arte, con los NFT también existe la posibilidad de hacer copias, pero todo el mundo sabrá que es una copia gracias a la transparencia e inmutabilidad de la Blockchain, por lo que podríamos afirmar que, los NFT son “obras de arte” digitales.

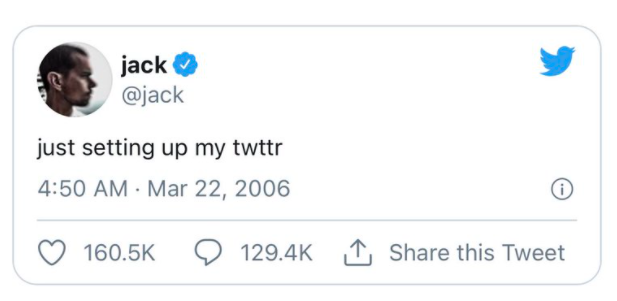

Aunque hemos hecho hincapié en su parecido a las obras de arte, los NFT pueden ser cualquier cosa que puedas imaginar; una foto, un meme, un artículo dentro de un videojuego o un tweet. Sí, un tweet. En 2021 el primer tweet creado en la plataforma se vendió por valor de 3 millones de dólares.

Si bien te pueden parecer extrañas o puntuales este tipo de transacciones multimillonarias, son más comunes de lo que piensas. En 2021 el interés por los NFT ha sido incontrolable, lo que ha dado lugar a operaciones desorbitadas:

Documento confidencial de la NASA: 5,27 millones de dólares.

Código original de la World Wide Web: 5,4 millones de dólares.

Dibujo en bits o “CryptoPunks”: 5,3 millones de dólares.

Ahora que comprendemos el significado y el uso que se le da a los NFT, os traslado la siguiente pregunta: ¿De qué manera se puede aplicar este activo digital a los negocios?

Los NFT se han convertido en un atractivo para las marcas a la hora de planificar su estrategia de Branded Content, ya que abren la posibilidad de comunicarse con el usuario y generar interacción con el mismo. Crea experiencias, aumenta el reconocimiento de marca y dota de interés los productos y servicios de la compañía.

En la actualidad, existen diversas empresas que trabajan con los NFT como vía de comunicación con sus usuarios. Es el ejemplo de Pizza Hut o McDonald’s, que han creado NFT de sus productos como coleccionables para fomentar su relación con los usuarios.

Otro caso muy interesante es el de la cadena de cines AMC, quien, en colaboración con Sony Pictures, regaló 86.000 NFT´s con la imagen de Spiderman para promocionar el estreno de su nueva película.

Viendo el éxito de esta estrategia, AMC Entertainment Holdings anunció en diciembre de 2021 la llegada de un nuevo NFT solo disponible para inversores.

En nuestro país el caso más conocido es el de Correos, quien ha lanzado mediante la tecnología Blockchain sus “Criptosellos”, con la intención de que tengan la misma utilidad que los sellos convencionales. La innovación de las empresas otorga un valor al usuario que puede influir en la relación con el mismo y en la imagen de marca que perciben sus clientes.

Los usuarios demandan a diario experiencias por parte de las empresas. La atracción de estos activos digitales en cientos de miles de personas dota de un gran potencial para las marcas en su estrategia de contenidos y, además, le permite testar nuevos modelos de generación de ingresos y de relación con los consumidores.

En definitiva y tras todo lo anteriormente expuesto, desde Grupo Ideonomía pensamos que no existen garantías de que los NFTs puedan suponer una revolución en los negocios, pero lo que sí es cierto, es que, por el momento, todo apunta a que han llegado para quedarse.

La transformación digital se puede definir como la integración de las nuevas tecnologías en todas las áreas de una empresa para cambiar su forma de funcionar. El objetivo es optimizar los procesos, mejorar su competitividad y ofrecer un nuevo valor añadido a sus clientes.

Desde hace unos años, la mayoría de las compañías no dejan de comentar como eje principal de sus activos la tan manida transformación digital de sus organizaciones.

¿Cuál es la verdad de todo esto? Según nuestra experiencia con clientes/compañías de todo tipo, no es cierto. No hay una estrategia clara y definida en la mayoría de las ocasiones y siguen inmersos en cambios parciales o parches que nada tiene que ver con la transformación digital.

¿Por qué ocurre esto? Miedo al cambio, falta de conocimiento, miedo a la tecnología, falta de visión transversal que, con la digitalización, te permita mayor conocimiento del cliente, mejoras en la comunicación, eficiencia en costes, etc.

Entendemos que a muchas compañías les cueste hacer el cambio, sobre todo a las más grandes, pero es inevitable hacerlo si no quieres perder cuota de mercado e interés por parte del consumidor/cliente.

Estos cambios, normalmente, suelen ser culturales, por tanto, muchas de las personas de la compañía no están preparados para asumirlo ni para salir de su zona de confort, con lo cual buscan excusas de todo tipo para comenzar a dar el paso. Este problema conlleva la necesidad de hacer sustituciones de cargos/personas que permitan que dichos cambios se hagan con la mayor rapidez.

La solución típica al problema, el parche que casi todas las empresas llevan a cabo es crear una división digital con la que comience la transformación. Dicha división digital tiene como principal ítem crear una página web y a través de ella generar el mayor número de ventas, replicando esto mismo al entorno móvil.

Esta división o equipo permanece aislada del resto de la organización, como un ente encapsulado, donde nadie del resto de la compañía entiende ni sabe lo que hace.

Este equipo no tiene información sobre la comunicación corporativa, ni la comercial, ni el CRM ni tampoco del Call o Contact Center, si acaso lo tuvieran contratado. Transformar la cultura de una empresa para que ésta sea más digital es una tarea muy complicada. Sin conocimiento previo, es difícil tener un pensamiento integrador que dé respuesta a todos los cambios que hay que realizar.

Esta realidad, guardando las distancias, es algo similar a lo que ocurrió hace más de 30 años con la incorporación del ordenador en las empresas. Ese momento también fue un cambio de paradigma, una manera completamente distinta de hacer las cosas, de compilar la información de una manera determinada, de recuperarla rápidamente, de ser más eficientes con el trabajo realizado y de tener más control sobre lo que se hacía.

¡¡Y qué decir de la llegada de internet y con ello de la incorporación y uso del correo electrónico!! Todavía recuerdo a más de una secretaria imprimiendo los correos para que los leyera el jefe porque no sabía ni como entrar en el correo… Lo dicho, cambio de paradigma y de personas que puedan empujar dicho cambio.

Mientras tanto, Grupo Ideonomía seguirá ayudando a entender, incorporar y formar a toda aquella empresa que lo necesite con la finalidad de hacer su travesía al cambio de una manera más sencilla.

No hay mayor inspiración para los temas que tratamos en el post que la propia experiencia que vivimos semana a semana con cada uno de nuestros clientes y las casuísticas que presentan.

Nos hemos encontrado en más de una ocasión con que los anunciantes llevan a cabo procesos “porque sí”, “porque se tienen que hacer”, pero sin un motivo o fin a largo plazo, incurriendo de esta forma en una ejecución procesos de trabajo en vano.

Siguiendo con el hilo de lo que comentábamos en el post anterior, el primer paso para no caer en este tipo de errores es tener clara la estrategia, aquella en la que se enmarcan cada uno de los procesos posteriores que nos van a permitir llevarla a cabo para acometer los objetivos que se tienen. Para ponernos un poco más en situación y que esto no sea un viaje por las ideas, me voy a centrar en uno de los activos principales para los anunciantes: su base de datos.

Partamos de la realidad del mercado, y es que no hay diez anunciantes, ni cien, hay muchísimos más en cada uno de los sectores con los que competir y para cuya lucha hay que estar preparados.

En varias ocasiones, nos hemos encontrado con amplias bases de datos carentes de valor, pues los usuarios recogidos en ellas están como llamamos, “dormidos”. Lo primero es el planteamiento ¿por qué debo crear una base de datos? ¿en base a qué criterios? Y si ya la tengo creada ¿he hecho bien mi trabajo?¿para qué la voy a utilizar? ¿qué le puedo ofrecer a mis usuarios que les merezca la pena para proporcionarme sus datos? Y por último ¿qué quiero conseguir de ellos?

No es tarea sencilla la de crear una base de datos fuerte pues se requiere de mucho tiempo, dedicación y mimo. No se puede conseguir una base de datos amplia y con sentido si no se tienen claros los criterios, hay que encontrar el equilibrio entre la cantidad y la calidad.

Si nos fijásemos en lo más simple y llano, podríamos establecer 3 factores a cumplir (partiendo del supuesto en el que ya tenemos una base de datos creada): fidelización, captación y explotación.

– Fidelización: Ya tengo a mis usuarios ¿y ahora qué?¿qué voy a hacer con ellos?¿los dejo dormir? Conocer a mis propios usuarios a fondo y clasificarlos en base a sus comportamientos nos va a permitir no solo enviar comunicaciones cada vez más personalizadas para perseguir el objetivo final, sino también para poder proyectar en ellos la búsqueda y captación de usuarios similares en cuanto a conductas, características y comportamientos. Mantener activos a los usuarios de nuestra base de datos y conseguir fidelizarles en base a lo que les ofrecemos será la clave para que la rueda siga funcionando. Si un engranaje falla, todo se para. La relación anunciante/usuario debe ser una relación win-win, donde el anunciante tenga cada vez más información de los usuarios y éstos a su vez, estímulos suficientes como para confiar y apostar por lo que se le ofrece.

– Captación: A la pregunta ¿tengo una base de datos suficiente? No, nunca es suficiente si tenemos un objetivo ambicioso que debemos conseguir. Así como tenemos que enfocarnos en la fidelización de los usuarios que ya tenemos, en paralelo se debe realizar el trabajo de seguir captando usuarios sin caer en la captación de adeptos “interesados o fugaces” que van a ofrecer sus datos al mejor postor. Hay que tener en cuenta que los usuarios son cada vez más exigentes y más recelosos de su privacidad, por lo que se hace cada vez más difícil ofrecerle valor a largo plazo. Por esto ¿Qué les voy a ofrecer? ¿Qué tengo de valor como anunciante que sea susceptible de interés para mis usuarios?

– Explotación: Por último, el paso al que todo anunciante quiere llegar sin tener claro si ha ejecutado los dos anteriores con rigurosidad y criterio, la explotación de la base de datos. Bien sea para ofrecerle mis productos y servicios a los usuarios o para la monetización de la misma en beneficio de la compañía, ¿tiene el valor suficiente mi base de datos como para poder ofrecerla en el mercado? Siempre vamos a hacernos preguntas para las cuales habrá diversas y múltiples respuestas. La correcta nos vendrá dada si el resto de procesos están, como decía al principio, enmarcada en la estrategia.

Por añadir más variables a los procesos de trabajo que debemos realizar en nuestras labores como profesionales del marketing, uno de los procesos que he citado justo antes es el de la búsqueda de nuevos usuarios en base a quienes ya se conoce en profundidad.

Algo importante a tener en cuenta es que, además de ser importante tener una base de datos amplia y de calidad, es primordial tener recogidas audiencias propias, es decir, usuarios que aún no conozco en profundidad pero que tengo en mi radar.

Con el futuro cercano y temido del que se ha hablado hasta la saciedad y que se ha ido retrasando, la desaparición de las cookies de terceros, se hace indispensable tener como anunciante el mayor volúmen posible de audiencias propias. Sí, aquí prevalece la cantidad pero sin perder el ojo en la calidad.

Gracias a herramientas como el DMP, tener recogidas estas audiencias es posible, pero además pudiendo categorizarlas y denominarlas en base a los criterios previamente establecidos para su posterior activación y eficiencia en las comunicaciones que les enviemos.

Hemos ido desde dentro hacia fuera poco a poco, desde nuestra base de datos propia de usuarios, hacia el reclutamiento y recogida de posibles adeptos, organizándolos y ubicándolos estratégicamente.

Se trata de procesos que tienen que tener su validez a largo plazo, haciendo uso de herramientas que permitan realizarlos con rapidez y además medir el impacto de las acciones que se llevan a cabo. El conocimiento adquirido sobre los datos que gestionemos de los usuarios van a permitir que los movimientos sean precisos y de calidad.

Para no perdernos en el camino, debemos no solo tener las bases conceptuales arraigadas, sino además perseguir un objetivo principal del que dependerán todas las acciones a llevar a cabo. Desde Grupo Ideonomía llevamos de la mano a nuestros clientes en este proceso con la pretensión de hacerles crecer tanto como sea posible y cómo no, crecer juntos en todos los sentidos.

En los últimos días hemos vivido en nuestras propias carnes varios hechos que nos han vuelto a reafirmar, que todavía aún existe un amplio recorrido de mejora en algunas estrategias de digitalización. Por poneros en situación, debido a un fantástico proyecto que ha caído en nuestras manos, hemos llegado a detectar algunos errores no muy banales en varias empresas de las que nos resultaba extraño imaginarlo debido a la envergadura y posicionamiento del que disponen dentro de mercados para nada irrelevantes.

¿Cómo puede estar ocurriendo que líderes de un sector puedan desprender esta sensación de mala ejecución del plan o incluso una ausencia de plan en algunas ocasiones? Lamentablemente la respuesta a esta pregunta bajo nuestra experiencia, es que, ocurre con más frecuencia de la que podemos pensar.

Para los que no conocéis el alcance de los servicios que ofrecemos en Grupo Ideonomía, deciros que, no solo somos una agencia de medios, sino que nuestro origen se remonta a la realización de proyectos de consultoría para tratar de apoyar a las empresas en su estrategia digital desde todos los ámbitos.

A mí personalmente me gusta utilizar el símil de Chicote y su puesta a punto de los restaurantes que visita, arremangándose y realizando un trabajo de campo para tratar de detectar los puntos de mejora para luego darles una solución y ejecutarla, por muy grande que sea la transformación que implique. Este mismo fin es el trabajo que buscamos realizar dentro de nuestro ámbito y es que, ante cada nuevo proyecto, el equipo trata de desgranar y evaluar con mimo ante qué nos enfrentamos.

Para este caso en concreto que os veníamos comentando en el inicio, fuimos testando uno por uno tanto a los actores relevantes del sector, como por supuesto a los no tan relevantes, pero que estaban empezando a despertar la atención de los consumidores. Porque, ojo, ¿Qué ocurre si de repente entrara alguien en el juego que haya visto una oportunidad? Un nuevo actor emergente que ya tenga en su ADN cómo se deben hacer las cosas en cuanto al canal digital se refiere, que tenga toda la información de cómo se comportan los clientes, y que además posea una estructura más ligera y una cultura nativa digital. Este podría llegar a lograr un modelo disruptivo que arrastre a los consumidores y dinamice el modelo de negocio tradicional hasta ahora conocido.

Porque no nos equivoquemos, estas olas de disrupción no son puntuales, pasa en todos los sectores, y para poder mantener la posición es importante tener una mente abierta y observar a estos nuevos actores que entran rompiendo con su forma tan diferente de hacer las cosas. Debemos estar pendientes de esas startups incumbentes que apuestan por los nuevos negocios, porque si se diera el caso de que los clientes de pronto las adopten de manera masiva, esa situación se convierte en el momento de la verdad. Y en ese punto de inflexión, las empresas que hayan apostado por este modelo se quedarán, y las que no han sido capaces de adaptarse (o lo hagan tarde), desaparecerán.

Cada vez se difuminan más los límites entre los sectores. Cuando una empresa cambia el minset de producto a cliente y tiene un acceso a él a través de todos los datos que puede recopilar, le permite diseñar productos mejores para esos clientes, dándoles acceso a un mercado nuevo, compitiendo en ámbitos donde no pensaban que iban a estar. Por eso es importante estar muy atento, o en su defecto, disponer de alguien que lo esté por ti ante cualquier innovación que esté habiendo y seguirla, ya que esto es una de las cosas que si trabajas en el día a día y a corto plazo no se le presta demasiada atención.

Volviendo a nuestro diagnóstico inicial sobre este nuevo sector en el que nos teníamos que sumergir, el primer shock fue encontrarnos a compañías que se hacían llamar digitales sin ni si quiera disponer de un canal digital para cerrar la venta.

Realmente nuestra conclusión es que nos encontrábamos ante un problema general del sector, nada atribuible a un actor en concreto. Esto se debe a uno de los principales motivos por los que los planes de transformación no tienen el resultado esperado: la falta de necesidad de urgencia.

Hasta ahora el pastel se lo han repartido entre muy pocos y muy tradicionales, no hay necesidad de cambio real. Esta postura puede llevar al error de luchar para continuar siendo relevante ignorando un mundo en el que están ocurriendo cosas, cual baño de realidad de Emma Stone a Michael Keaton en la película Birdman.

Otro de los problemas detectados ha sido la ceguera por ser digital poniendo de manera genérica más foco en la tecnología como herramienta. En normas generales, podemos decir que la mayoría de este perfil de empresas están poniendo más énfasis en la palabra digital que en la palabra transformación, no siendo capaces de adaptarse o transformarse, replicando los mismos procesos tradicionales en el canal digital.

Bajo nuestro criterio, para este tipo de investigaciones no solo basta con analizar el proceso de venta digital que recorre el usuario. Existen unas fases críticas de cara al cliente, desde la generación de tráfico hasta la postventa y cumplimiento de la promesa efectuada. Debemos observar, por tanto, todos esos puntos de contacto desde los que el usuario también se informa y decide, por lo que siempre evaluamos en detalle el estado de cada uno de sus medios propios, webs, apps perfiles sociales…Cómo se están utilizando esos espacios en blanco para mostrarse hacia el posible cliente, y si existe en conjunto una estrategia unificada en torno a todos ellos, mejorando la conexión directa con el cliente.

Durante este análisis de medios propios es donde se produce el más fiel reflejo del estado interno de la organización, ya que aquí es donde podemos comprobar si todos los departamentos trabajan coordinados y empujando hacía el crecimiento del negocio bajo una misma estrategia o, por el contrario, existen silos que trabajan bajo objetivos departamentales. No concebimos que sea posible realizar una estrategia de contenidos en Youtube sin tener en cuenta una estrategia de posicionamiento, como tampoco concebimos una estrategia SEO que persiga generar tráfico perdiendo la perspectiva de negocio. ¿Hay que estar en todas las RRSS?, ¿hay que hablar en todas ellas en el mismo tono, con la misma frecuencia, del mismo tema…?

Tras exponer las conclusiones de este tipo de informes a interesados que quieren poner solución a dichos errores, la primera reacción que solemos encontrar es frustración, ya que se suelen topar internamente con estructuras rígidas y direcciones que permiten, pero bajo restricciones. Si por el contrario tienen la buena suerte de encontrarse bajo un liderazgo que realmente quiera realizar esos cambios, y que haya tenido la inteligencia de solicitar ayuda, en un breve periodo de tiempo se pueden trabajar soluciones que aúnen la estrategia de todos estos puntos de contacto. De esta manera, se aprovecharíantodos ellos para la obtención de datos, y estos datos, a su vez, ser utilizados para reducir costes, mejorar la experiencia del usuario y aumentar la proactividad y capacidad de previsión a través de modelos predictivos.

Para concluir, nos gustaría resaltar el punto más importante que se debe priorizar antes de realizar cualquier cambio: tener clara tu visión y estrategia digital. Después continuaremos con el punto más útil, el de poner el mayor empeño para vencer el obstáculo más difícil que nos podemos encontrar en la fase de implantación: el factor humano. Para evitar la alta resistencia al cambio, se debe trabajar la comunicación y cultura digital tratando en todo momento de incentivar la colaboración y agilizar la toma de decisiones. Como solemos decir en Grupo Ideonomía: “Remar todos en la misma dirección”.

De todos los aquí presentes, ninguno puede negar que actualmente vivimos en un mundo en el que las redes sociales, de una manera u otra, forman parte de nuestro día a día. Algunos las usamos únicamente para comunicarnos con nuestro círculo más cercano (o no tan cercano), otros para practicar nuestros mejores movimientos de baile y, algún valiente, incluso, las utiliza para intentar encontrar el amor.

Pero, independientemente del uso que cada uno quiera darle, están ahí y permiten que estemos conectados de manera casi inmediata. Precisamente eso es lo que resume el triunfo de las redes sociales: ofrecer a los usuarios una forma de comunicación a través de espacios virtuales, sin importar en qué lugar del planeta se encuentren, y, en la gran mayoría de los casos, de manera gratuita (o eso pensamos).

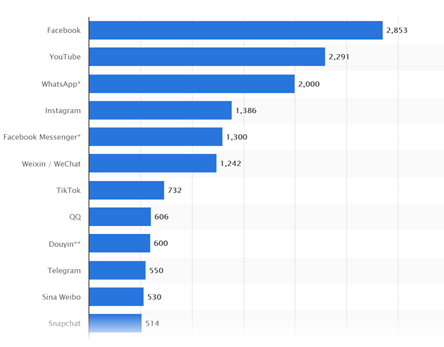

Según datos arrojados a principios de este año por Hootsuite, el número total de usuarios en redes sociales por aquel entonces era de 4.200 millones de personas, lo que supondría una representación del 53,6% sobre el total de la población mundial. Además, si comparamos estos datos con los del mismo periodo del año anterior, se aprecia un incremento del 13,2%, por lo que las cifras nos indican que esta tendencia a corto plazo seguirá creciendo al mismo ritmo o incluso a mayor velocidad de la alcanzada hasta el momento.

Entre las redes más utilizadas, Facebook tiene el pódium del mercado, seguido de las plataformas de Youtube y Whatsapp. Además, la compañía de Mark Zuckerberg también posee otras tres de las redes sociales más grandes, todas con más de mil millones de usuarios activos mensuales. Estas son: el ya mencionado WhatsApp, Facebook Messenger e Instagram.

Pero ¿qué pasaría si un gigante como Facebook se “apaga” durante 6 horas seguidas sin previo aviso?

Pues justo eso es lo que tuvimos que descubrir el pasado 4 de octubre. A pesar de que esta situación ya se había dado con anterioridad, generalmente había sido en periodos de tiempo más cortos y en una plataforma en concreto (no en las tres a la vez). Además, el motivo reportado en estos casos por parte de la compañía ha sido achacado, citando palabras textuales, a “problemas técnicos”, sin llegar a profundizar mucho más en el tema. En esta ocasión, sin embargo, las razones han salido a la luz.

Para entender cuál fue la causa de esta caída a nivel mundial, debemos saber que Internet es una gran red de redes que funciona gracias al uso de grandes routers constituidos por enormes listas de posibles rutas para llevar un paquete de datos desde un punto a otro.

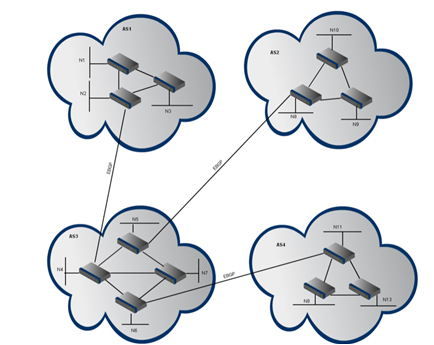

Para que esto funcione, se hace uso de un protocolo, y ahí es donde entran en juego los Border Gateway Protocol o más comúnmente conocidos como BGP’s. Como definición, un BGP es un protocolo que se utiliza para intercambiar información de encaminamiento de diferentes sistemas autónomos (AS) y para facilitar el intercambio de información sobre redes IP.

Cada uno de estos sistemas autónomos, tendrá conexiones o sesiones internas (iBGP), así como sesiones externas (eBGP), por lo que se considera que, un BGP es un protocolo interdominio (entre sistemas autónomos) e intradominio (dentro del mismo sistema autónomo).

Todo esto, se sostiene gracias a una sesión de comunicación basada en TCP (Protocolo de control de transmisión o, en inglés, Transmission Control Protocol) que permite que cada uno de los extremos de la comunicación puedan intercambiar adecuadamente la información.

Es decir, se mantienen sesiones BGP sobre TCP para que pueda llevarse a cabo la comunicación entre los sistemas autónomos. Por otro lado, es importante tener en cuenta que, existe más de una ruta posible entre dos sistemas autónomos y que, por otro lado, es posible tener más de un router de borde (BGP) en el mismo sistema autónomo, tal y como puede observarse en la siguiente imagen:

Entre todas estas redes de Internet se encuentra Facebook (entendido como sistema autónomo (AS) o red individual), con una serie de normas internas y unificadas de enrutamiento de paquetes. La plataforma, a través del BGP anunciaba sus rutas y las hacía accesibles, sin embargo, en un momento dado, Facebook dejó de anunciar estas rutas prefijadas, en concreto aquellas que encaminaban a su dominio (DNS o Domain Name System) y ahí empezó el caos. Al dejar de anunciar el prefijo de enrutamiento de sus DNS, los servicios de resolución de DNS (aquellos que permiten navegar por Internet utilizando nombres de dominio en lugar de direcciones numéricas) no tuvieron forma de conectar a sus servidores de nombres.

Entre las grandes consecuencias de este error podemos destacar:

– La huida de los usuarios a otras plataformas como Twitter o Telegram, lo que demostró que, aunque parezca que el mercado de las redes sociales está monopolizado, también existen otras alternativas que dan el mismo servicio. Incluso Facebook fue el primero que hizo uso de Twitter para comunicar a sus usuarios que estaban tratando de resolver el problema.

– El hecho de que las tres grandes redes sociales (Facebook, Whatsapp e Instagram) pertenezcan a la misma compañía, hizo que todo estuviera unido y cayeran simultáneamente provocando una gran frustración entre los de millones de usuarios de sus plataformas.

– En el mundo del marketing y la publicidad, tampoco dejó indiferente a nadie: campañas pausadas con inversiones ya realizadas y planificaciones temporales específicas. Los anunciantes dejaron de aparecer durante las seis horas que Facebook no estuvo disponible.

– En la bolsa de valores, Facebook vio una caída de casi el 5% en el valor de sus acciones.

– Para más inri, durante la caída de Facebook, el dominio «Facebook.com» apareció a la venta en la herramienta Domain Tools, lo que hizo pensar a gran parte de los usuarios que se trataba de un hackeo, algo que posteriormente fue desmentido por la compañía.

– Escándalo social agravado por la previa controversia generada por unos archivos internos filtrados a la prensa de EE.UU. por una exempleada, cuyo contenido agravó más el revuelo público generado por la caída.

La conclusión a la que se ha llegado una semana más tarde del suceso, es que el cambio “defectuoso” en la configuración de los routers que coordinan el tráfico entre los centros de datos de la compañía, según los expertos, podría atribuirse a un error humano. La teoría es que una persona interna de la compañía, borró accidentalmente la información de los servidores, lo que provocó la desaparición de los servicios de Facebook en Internet como si nunca hubiesen existido.

A pesar de que no lo hayan confirmado de manera oficial desde la empresa, aparentemente, estos sistemas son muy fuertes, pero hasta el líder del mercado de las redes sociales puede cometer el más “mínimo” fallo y perder en un solo día alrededor de 6.000 millones de dólares.

Lo anteriormente mencionado, es algo que se puede extrapolar a cualquier ámbito laboral, en el que un error puede generar pérdidas de miles y miles de euros, por lo que es importante que todos los miembros del equipo sean precisos en su trabajo y conscientes de que los datos y los números pueden ser infinitos, pero los errores en este tipo de entornos, por desgracia, no lo son.

Fuentes utilizadas:

https://www.lavanguardia.com/vida/junior-report/20200702/482045667909/mundo-redes-sociales.html

https://www.statista.com/statistics/272014/global-social-networks-ranked-by-number-of-users/

https://www.elmundo.es/tecnologia/2021/10/04/615b2224fdddff5b448b4570.html

En los últimos años, la tendencia del marketing de influencers se ha ido consolidando como una de las tácticas más utilizadas para potenciar colaboraciones entre marcas y empresas mediante figuras de gran “influencia” (perdón por la reiteración) y visibilidad en Internet, principalmente en las redes sociales, y cuyo auge las ha impulsado al podio de los medios con más potencial para alcanzar usuarios a gran escala.

Anteriormente ya os hablamos de la capacidad de estos ‘influencers’ a la hora de convertirse en grandes referentes para multitud de consumidores en redes, generando un enorme volumen de suscriptores en plataformas como TikTok, Instagram, Twitch o Youtube. Esta reciente inclinación ha propiciado la creación de más campañas en redes enfocadas a fomentar la conversación social, promocionar un producto o mejorar la reputación de una marca.

Según un reciente estudio elaborado por Infoadex, el marketing de influencers generó más de 75 millones de euros en el año 2020, solo en España (un 22,3% más que en el periodo anterior). A su vez, los pronósticos futuros respecto a la inversión dentro de este sector estiman que se alcanzarán los 240 millones de euros para 2024. Este aumento de campañas promocionadas a través de celebridades viene amparado por un estudio de Nielsen Media, el cual estipula que son cuatro veces más recordadas por la audiencia, consiguiendo aumentar la consideración de compra de los usuarios hasta 17 puntos por encima en comparación con clientes no expuestos a las mismas.

Actualmente disponemos de herramientas de análisis ya probadas que nos ayudan en la medición y optimización de campañas, sin embargo, nos encontramos ante un nuevo mercado en el que se necesitan variables adaptadas a los requisitos que este tipo de promociones demandan, con el fin de sacarles el mayor provecho y rentabilidad posible. Esta creciente influencia en el sector (perdón de nuevo), implica el desarrollo de un plan estratégico notable abordando cada decisión del proceso (qué tipo de influencer se adecua más a los contenidos promocionados, objetivos a marcar, o la plataforma idónea) de una forma certera y justificada. Afortunadamente, esta necesidad ya ha sido respondida por la misma Nielsen.

La empresa de investigación de audiencias presenta Influence Scope, la llamada “solución para la medición de las acciones de marketing de influencia que ofrece una visión global desde una única plataforma”. Gracias a una base de datos formada por más de 96 millones de influencers que cubren las diferentes redes sociales (bloggers, gamers, microinfluencers…), Influence Scope desembarca como una herramienta tecnológica de mejora de las distintas acciones que componen el marketing de influencia durante todo el ciclo de vida de una campaña, ofreciendo datos constantes para conseguir un retorno de la inversión óptimo.

Esta novedosa herramienta goza de un modelo de puntuación basado en los ‘cuatro elementos clave’ para el marketing de influencia, contando con una amplia cobertura en la medición de plataformas y páginas web. Además, la herramienta ya se ha testado en otros mercados internacionales a través de cuentas como Coca-Cola, Calvin Klein o Mercedes Benz. Estos cuatro factores que se deberían tener en consideración a la hora de abordar una campaña exitosa y así obtener un ROI favorable son:

– Definición de un presupuesto fijo desde la activación de campaña.

– Regir la creación de contenidos, elaboración de ideas y ejecución de estrategias en base a los insights que aporta el mercado.

– Desarrollo de campañas que obtengan un ROI medible en tiempo real para cada acción.

– Facilitar el proceso de visualización, medición y recopilación de las acciones ejercidas a través de una única plataforma, con información y cobertura real y actualizada.

De esta forma, Influence Scope llega en un momento de máximo apogeo para el marketing de influencia en España, cuya implantación y consumo se ve patente en plataformas como Twitch o TikTok. Pero esto es solo la punta del iceberg ya que, en un comunicado realizado para marketingdirecto, la directora de Nielsen Media para España y Portugal, Maira Barcellos, asegura que “esta revolución en el marketing de influencers se está implementando en más países, suponiendo un recurso potencial y necesario de análisis real para un medio tan complejo como es el Social Media”. Además, la herramienta facilita la ayuda de un soporte especializado en proyectos de esta envergadura para personalizar las estrategias y acciones de las marcas y agencias que lo requieran.

Aún es pronto para conocer la evolución que tendrá esta nueva aplicación, así como su utilidad y desempeño en el sector del análisis digital. Con la ‘escueta’ información de la que disponemos, es difícil saber si dejará huella en el mercado o no. Sin embargo, su inclusión abre las puertas a una serie de preguntas recomendadas de hacerse: ¿Realmente es necesario una nueva herramienta para la medición de campañas de influencers? ¿De verdad nos encontramos ante un ámbito tan complejo que ni si quiera las analíticas actuales son capaces de abarcar?

El dominio de los ‘influencers’ en el sector publicitario está en ascensión, eso es un hecho. Más remarcado incluso, tras conocer que la Comisión Nacional de los Mercados y de la Competencia (CNMC) ha propuesto incluir a estos prescriptores en la Ley General de Comunicación Audiovisual, con el fin de regular una actividad de cada vez mayor importancia e inversión en comunicación. Esta propuesta de anteproyecto da prioridad a la identificación de ‘acciones comerciales’ en todos los contenidos publicitarios que se difundan, además de contemplar la obligación por parte de las plataformas de implementar sistemas de verificación de edad respecto a los contenidos ofrecidos (un adelanto que ya están cumpliendo plataformas como Instagram).

Por otro lado, ya existen herramientas que aportan datos de gran valor para el desarrollo de campañas con estas características: Heepsy, Brandwatch, o Fake follower check, son aplicaciones que facilitan las decisiones en el desarrollo estratégico de influencers, desde la verificación de la cuenta escogida, hasta búsquedas por contenidos y audiencia de cada prescriptor. Influence Scope (según su carta de presentación), ofrece una visión más global desde una única plataforma, abarcando la medición general de la campaña en sí y no solo centrándose en lo que podrían considerarse ‘pasos estratégicos previos’.

Esta “visión global” deberá abordar aquellos factores clave que permitan realizar una medición efectiva, como la interacción o engagement de los seguidores, elemento crucial para conocer el verdadero potencial de un prescriptor. Ahora bien, ¿no hemos mencionado ya plataformas que se encargan precisamente de esto? A niveles técnicos específicos que se diferencien del resto, Influence Scope se queda un poco coja si nos centramos en las acciones analíticas generales. Quedará saber (esperemos que próximamente y con más detalle), qué puede aportar la herramienta en un mercado con cada vez mayores ofertas.

Se abre así un nuevo portal de medición en el juego del marketing. Las marcas disponen de otra oportunidad para potenciar la captación de sus usuarios, aportando valor a través de las estrategias más adecuadas para plataformas de notoriedad creciente, y con unos nuevos agentes que, prejuicios aparte, están campando a sus anchas en esta era de digitalización del entorno, ¿Cuántas hectáreas serán capaces de cubrir? Ahora tenemos otra herramienta para saberlo.

Fuentes utilizadas:

- https://www.reasonwhy.es/actualidad/nielsen-trae-espana-herramienta-medir-roi-nfluencers

- https://www.grupoideonomia.com/marketing-de-influencers/

- https://www.marketingdirecto.com/digital-general/digital/influencescope-exito-marketing-influencers

- https://www.reasonwhy.es/actualidad/marketing-influencers-crece-cuentas-pequenas-nueva-regulacion

- https://www.eleconomista.es/tecnologia/noticias/11373839/08/21/Instagram-te-va-a-pedir-tu-fecha-de-nacimiento-y-no-podras-usar-la-app-si-te-niegas-.html

- https://www.inboundcycle.com/blog-de-inbound-marketing/marketing-de-influencers-herramientas-para-medir-su-efectividad

- https://www.launchmetrics.com/es/recursos/blog/medir-marketing-influencers

Según un estudio de la empresa DOMO, cada minuto que pasa, los más de 4.500M de personas que tienen acceso a internet envían 42M de mensajes de WhatsApp, se instalan 2.704 veces la aplicación TikTok, suben 500 horas de vídeo a YouTube, se unen 319 nuevos seguidores en Twitter, publican casi 348.000 posts en Instagram, y suben más de 147.000 fotografías a Facebook. Son cifras que nos hacen pensar, y replantearnos lo realmente pequeños que podemos ser en este amasijo binario llamado internet.

A nivel empresarial, los datos son una fuente muy valiosa en la que apoyarnos para la toma de decisiones, tanto para pequeñas como para grandes empresas. Con ellos podemos comprobar si realmente estamos llegando a los objetivos marcados. Un buen uso y análisis de los datos le puede dar a la empresa la capacidad de conocer y entender a sus clientes potenciales.

Desde que se puso en marcha la nueva normativa europea de protección de datos (RGPD), todo el entorno digital ha experimentado un endurecimiento de las medidas de protección de la privacidad, y parece que, las plataformas de marketing no solo han asimilado estas medidas, sino que han impuestos sus propias restricciones. Lo vimos con la App Tracking Transparency de Apple o con el comentado fin de las cookies de terceros por parte de Google (Chrome). Esto genera un cierto cambio a nivel analítico, ya que complica el proceso de medir a estos usuarios que no aceptan voluntariamente la política de privacidad.

Los profesionales del sector publicitario nos encontramos diariamente con multitud de problemas a los que debemos de dar solución. Uno bastante común con el que tenemos que lidiar es con las discrepancias que existen entre los datos que nos reportan las herramientas de marketing digital. Como hemos dicho, hoy en día los datos son uno de los activos más importantes de los que dispone la empresa, por lo que no es de extrañar que cuando las distintas plataformas informan de datos que no coinciden entre sí, la situación se ponga bastante tensa.

Pero tranquilicémonos, porque normalmente estos problemas suelen tener una solución, o al menos, una explicación coherente que en muchas ocasiones tiene relación directa con el comportamiento natural del usuario.

Por eso, vamos a hablar de un problema común que encontramos en nuestro día a día, como, por ejemplo, la discrepancia que se produce entre los clics que generan nuestras campañas, y las sesiones que vemos en una herramienta analítica como puede ser Analytics.

Lo primero, tenemos que tener claro la diferencia que existe entre estos dos conceptos, que, aunque creamos que son similares, pueden llegar a ser muy diferentes:

Un clic se produce cuando un usuario hace clic en alguno de nuestros anuncios. Parece simple ¿no? Hay que tener en cuenta que, algunas plataformas como Facebook, cuentan con métricas que, a priori, parecen iguales, pero que recogen datos que varían mucho entre sí, por ejemplo, los clics totales, y, por otro lado, los clics en el enlace. Estos últimos son los que nos interesan, ya que son los que conducen a los usuarios directamente a nuestro site. Pero el viaje no se acaba aquí, aún queda un largo trayecto para que ese potencial clic se convierta en una bonita sesión.

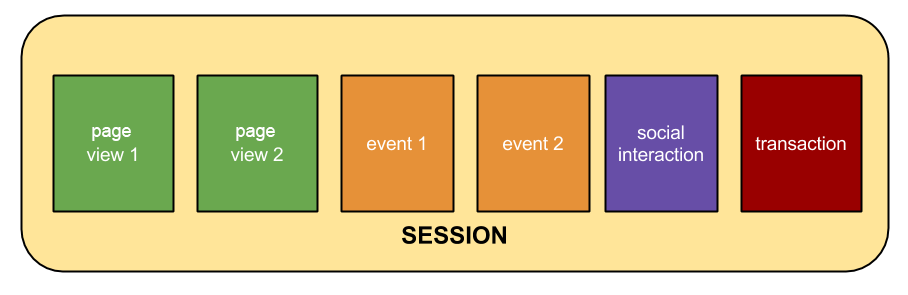

La sesión es el periodo que transcurre desde que se empieza a interactuar con nuestro sitio web y hasta que se abandona. Si el usuario permanece inactivo durante más de 30 minutos o cierra el navegador se considera finalizada la sesión. En términos técnicos, una visita se denomina sesión. Una única sesión puede contener varias vistas de página, eventos, etc.

Fuente: Support Google

También parece fácil ¿no? Ahora subamos un nivel y pongámonos un poco más técnicos.

Para que un clic se convierta en sesión, deben de tener lugar varios requisitos:

1. Una vez que hacemos clic en un anuncio, nuestro navegador se dirige a la página de destino en cuestión.

2. El sitio web del anunciante responde a la solicitud que hemos enviado, y comienza a transferir datos desde el servidor de la web al navegador del usuario.

3. El navegador del usuario empieza a descargar la información de la web, código JavaScript, CSS, imágenes, video, audio, etc. Entre el código JavaScript se encuentra el código de seguimiento de Analytics que permite la medición de la web.

4. El archivo JavaScript (ga.js o analytics.js) primero debe ser descargado e interpretado por el navegador del usuario.

5. El navegador del usuario y la configuración de seguridad deben admitir:

– Cookies

– Javascript

– Imágenes

6. A continuación, el navegador envía una solicitud por separado a los servidores de Analytics.

7. Se registra una sesión.

*Fuente: Adform

Como veis, la cosa se complica, por lo que, si algo falla, tenemos que mantener la mente fría y comprobar todo el trayecto que tiene que recorrer un clic para convertirse en sesión, y en caso de que existiera un problema, poder dar con la posible solución.

Estos problemas pueden deberse a multitud de factores, normalmente, la principal razón de la discrepancia se debe a los clics involuntarios. Esto suele darse sobre todo en dispositivos móviles, por ejemplo, al pulsar en el anuncio mientras se hace scroll, o querer cerrar el anuncio y pulsar por error en el enlace de redirección.

En menor medida, otros problemas que puedan generar diferencias entre plataformas pueden ser:

– Carga de la página. Una página que tenga una latencia alta (tiempo de carga), puede hacer que el usuario no llegue a acceder.

– Política de privacidad. Si el usuario no acepta la política de privacidad, no podremos medirlo en la herramienta de analítica.

– Problemas de configuración de la analítica.

– Clics fraudulentos. Clics generados por bots.

No todos estos problemas tienen solución, y siempre va a existir una discrepancia entre plataformas, pero al menos, debemos de configurar todo correctamente para que esta diferencia sea mínima. Algunos consejos para reducirla son:

– Genera informes de manera recurrente. Saber qué está sucediendo en cada momento es fundamental para localizar discrepancias.

– Utiliza detectores de clics fraudulentos. La mayoría de los servidores de anuncios suelen tener herramientas de filtrado de bots, pero también existen empresas especializadas en este tipo de servicio.

– Comprueba los formatos de forma independiente. Sobre todo, en dispositivos móviles. Analiza si hay algún formato en especial que tenga una discrepancia mayor para excluirlo. Esto puede tener mucha relación con los clics involuntarios de los que hablábamos anteriormente.

– Modificar el banner de consentimiento de privacidad. Debemos de colocar el banner de aceptación de cookies en una ubicación visible, si es posible, obligando al usuario a aceptar o rechazar para poder acceder al site.

En definitiva, las discrepancias entre datos son una realidad que ocurre, y que seguirá ocurriendo. Lo conveniente en estos casos, es ponerte en contacto con profesionales, ya que el mejor análisis que puede haber para dar con este tipo de problemas es la experiencia y una buena taza de paciencia.